Python-面试题(面试)

进程、线程、协程

什么是进程、线程、协程?以及它们的优缺点?

-

进程(Process)

- 定义:进程是操作系统分配资源的基本单位,每个进程都有自己独立的内存空间和系统资源。

- 优点:

- GIL限制:Python 的全局解释器锁(GIL)限制了同一时间只能有一个线程执行字节码,但进程间互不影响,可以利用多核 CPU。

- 独立性:每个进程都有独立的内存空间,一个进程崩溃不会影响其他进程。

- 缺点:

- 开销大:创建和销毁进程的开销较大,进程间通信(IPC)相对复杂。

- 资源消耗高:因为每个进程都有独立的资源,占用的系统资源较多。

-

线程(Thread)

- 定义:线程是进程中的一个执行单元,多个线程共享同一进程的内存空间和资源。

- 优点:

- 轻量级:线程的创建和销毁开销小于进程。

- 共享资源:线程间通信和数据共享比进程更方便。

- 缺点:

- GIL限制:由于 GIL,同一时间只能有一个线程执行 Python 字节码,影响多线程程序在 CPU 密集型任务中的性能。

- 同步问题:需要小心处理线程同步,避免竞争条件和死锁。

-

协程(Coroutine)

- 定义:协程是一种轻量级的线程,它们在一个线程内进行调度,允许在一个函数执行过程中暂停并在稍后恢复执行。

- 优点:

- 轻量级:协程切换的开销非常小,不涉及系统调用。

- 无阻塞:适合 I/O 密集型任务,例如网络请求和文件操作。

- 简化异步编程:使得异步编程更加直观和可维护。

- 缺点:

- 单线程局限:无法利用多核 CPU 并行执行 CPU 密集型任务。

- 同步问题:和线程一样,共享同一线程的资源,存在相同的同步问题。

-

总结

- 进程:适合 CPU 密集型任务,可以突破 GIL 限制,资源消耗高。

- 线程:适合 I/O 密集型任务,但受 GIL 限制,需注意同步问题。

- 协程:非常轻量级,适合大量 I/O 密集型任务,但无法利用多核 CPU。

Python 多线程和全局解释器锁(GIL)

-

Python 多线程

多线程是一种并发编程的方法,它允许多个线程在同一个进程内同时运行。线程共享整个进程的资源,包括内存空间和文件句柄,因此在线程之间进行数据共享和通信非常方便。

-

全局解释器锁(GIL)

GIL(Global Interpreter Lock,全局解释器锁)是 Python 解释器(CPython 实现)中的一个机制,它限制了在任何时刻只有一个线程执行 Python 字节码。这是为了确保对 Python 对象的内存管理是线程安全的,但也导致了一些性能问题,特别是在多线程环境下。

-

GIL 的存在原因:

- 内存管理安全:Python 的内存管理不是线程安全的,GIL 确保了在一个时刻只有一个线程操作对象,这样可以避免竞争条件和数据不一致。

- 简化实现:GIL 简化了 Python 解释器的实现,使得许多操作变得更简单、更高效。

-

GIL 的影响:

- CPU 密集型任务:对于 CPU 密集型任务,多线程应用表现不佳,因为 GIL 限制了并行执行,多个线程竞争 GIL,导致性能受限。

- I/O 密集型任务:对于 I/O 密集型任务(文件读写、网络请求等),多线程仍然能够带来性能提升,因为 I/O 操作会释放 GIL,使得其他线程能够运行。

-

解决方案:

- 多进程:使用

multiprocessing模块创建多个进程,每个进程都有自己的 Python 解释器实例和 GIL,可以充分利用多核 CPU。 - 异步编程:使用

asyncio模块进行协程编程,适合处理大量 I/O 密集型任务。 - 其他解释器:使用不包含 GIL 的 Python 实现,例如 Jython(基于 Java 的 Python 实现)和 IronPython(基于 .NET 的 Python 实现)。

- 多进程:使用

-

总结

- 多线程:在 Python 中,通过

threading模块实现,但受 GIL 限制,特别是在处理 CPU 密集型任务时。 - GIL:全局解释器锁限制了同时只能有一个线程执行 Python 字节码,确保了线程安全但也限制了多线程的性能。

- 解决方案:对于 CPU 密集型任务,可以使用多进程;对于 I/O 密集型任务,可以使用多线程或异步编程。

- 多线程:在 Python 中,通过

Python 中并发和并行有啥区别?

-

并发(Concurrency)

- 定义:并发是指在同一时间段内,系统能够处理多个任务,但并不要求这些任务同时进行。重点在于任务的切换和调度。

- 特点:

- 多个任务可以在同一个处理器核心上交替执行。

- 任务的执行顺序是交错的,但不一定是同时的。

- 适用于 I/O 密集型任务,如网络请求、文件读写等。

- 在 Python 中的实现:

- 多线程:使用

threading模块。 - 协程:使用

asyncio模块。

- 多线程:使用

-

并行(Parallelism)

- 定义:并行是指多个任务在同一时刻同时执行。重点在于任务的同时进行,通常需要多核处理器。

- 特点:

- 多个任务在多个处理器核心上同时执行。

- 提高了任务的执行速度,减少了总执行时间。

- 适用于 CPU 密集型任务,如复杂计算、图像处理等。

- 在 Python 中的实现:

- 多进程:使用

multiprocessing模块。 - 分布式计算:使用分布式计算框架,如 Dask、Ray 等。

- 多进程:使用

-

比较

- 并发:

- 多任务在同一时间段内交替进行。

- 适合 I/O 密集型任务。

- Python 中可以通过多线程和协程实现。

- 受 GIL 影响,Python 的多线程在 CPU 密集型任务中表现不佳。

- 并行:

- 多任务在同一时刻同时进行。

- 适合 CPU 密集型任务。

- Python 中可以通过多进程实现。

- 由于每个进程有自己的 GIL,多进程可以充分利用多核 CPU。

- 并发:

-

总结

- 并发侧重于任务的调度和管理,使多个任务在同一时间段内交替进行。主要用于 I/O 密集型任务,可以通过多线程和协程实现。

- 并行侧重于任务的同时执行,使多个任务在同一时刻并行进行。主要用于 CPU 密集型任务,可以通过多进程实现。

Python 如何提高并发?

-

使用多线程(Threading)

多线程适用于 I/O 密集型任务,如文件读写、网络请求等。尽管受限于全局解释器锁(GIL),但在 I/O 密集型任务中,多线程仍然能够带来显著的性能提升。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20import threading

import requests

def fetch_url(url):

response = requests.get(url)

print(f"Fetched {url} with status {response.status_code}")

urls = ["http://example.com", "http://example.org", "http://example.net"]

threads = []

for url in urls:

t = threading.Thread(target=fetch_url, args=(url,))

threads.append(t)

t.start()

for t in threads:

t.join() -

使用多进程(Multiprocessing)

多进程适用于 CPU 密集型任务,因为每个进程都有自己的 Python 解释器实例和 GIL,可以利用多核 CPU 进行并行计算。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17from multiprocessing import Process

def compute_square(num):

print(f"Square of {num} is {num * num}")

if __name__ == "__main__":

processes = []

for i in range(5):

p = Process(target=compute_square, args=(i,))

processes.append(p)

p.start()

for p in processes:

p.join() -

使用协程(Asyncio)

协程是一种轻量级的并发实现,特别适用于大量 I/O 密集型任务。协程通过事件循环来管理任务的调度,非常高效。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18import asyncio

import aiohttp

async def fetch_url(session, url):

async with session.get(url) as response:

print(f"Fetched {url} with status {response.status}")

async def main():

urls = ["http://example.com", "http://example.org", "http://example.net"]

async with aiohttp.ClientSession() as session:

tasks = [fetch_url(session, url) for url in urls]

await asyncio.gather(*tasks)

asyncio.run(main()) -

使用并发库(如 concurrent.futures)

concurrent.futures提供了一种高级接口来方便地实现多线程和多进程并发,可以通过ThreadPoolExecutor或ProcessPoolExecutor来实现。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17from concurrent.futures import ThreadPoolExecutor, as_completed

import requests

def fetch_url(url):

response = requests.get(url)

return url, response.status_code

urls = ["http://example.com", "http://example.org", "http://example.net"]

with ThreadPoolExecutor(max_workers=3) as executor:

futures = [executor.submit(fetch_url, url) for url in urls]

for future in as_completed(futures):

url, status = future.result()

print(f"Fetched {url} with status {status}") -

使用异步 Web 框架(如 FastAPI, Tornado)

对于 Web 应用,可以使用异步 Web 框架来提高并发性能。这些框架能够处理大量并发请求,非常适合 I/O 密集型 Web 服务。

1

2

3

4

5

6

7

8

9

10

11

12

13

14from fastapi import FastAPI

import aiohttp

app = FastAPI()

async def fetch_url(url: str):

async with aiohttp.ClientSession() as session:

async with session.get(url) as response:

return {"url": url, "status": response.status}

# 运行命令:uvicorn filename:app --reload

-

选择适合的并发模型

- 多线程:适合 I/O 密集型任务,可以通过

threading或concurrent.futures.ThreadPoolExecutor实现。 - 多进程:适合 CPU 密集型任务,可以通过

multiprocessing或concurrent.futures.ProcessPoolExecutor实现。 - 协程:适合大量 I/O 密集型任务,可以通过

asyncio实现。 - 异步 Web 框架:适合高并发 Web 服务,可以使用 FastAPI 或 Tornado。

- 多线程:适合 I/O 密集型任务,可以通过

线程上下文开销大是指什么?

-

简介

在计算机科学中,线程上下文开销指的是在线程之间切换所需的资源消耗和时间开销。这包括保存和恢复线程的状态信息,如寄存器、程序计数器、栈指针等。在 Python 中,也存在线程上下文开销,特别是在多线程编程中。

-

线程上下文开销的具体内容:

- 寄存器状态保存与恢复:

- 当线程切换时,当前线程的寄存器状态(如通用寄存器、程序计数器、栈指针等)需要保存到内存中。

- 新的线程则需要将其寄存器状态从内存中恢复到 CPU 寄存器。

- 内存页切换:

- 线程的栈和全局变量可能驻留在不同的内存页中,切换线程时可能会导致内存页切换,这也会带来一定的开销。

- 内核调度:

- 线程切换通常需要内核的调度器介入,以决定下一个要运行的线程。这个过程涉及系统调用和内核态的处理,增加了额外的开销。

- 缓存无效化:

- 线程切换可能会导致 CPU 缓存无效化(cache invalidation),降低缓存命中率,从而影响性能。

- 寄存器状态保存与恢复:

-

在 Python 中的影响

Python 中的多线程受限于全局解释器锁(GIL),GIL 确保在任何时刻只有一个线程执行 Python 字节码。尽管 GIL 确保了线程安全,但也带来了额外的上下文切换开销。

- GIL 争用:在多线程程序中,不同线程争用 GIL 会导致频繁的锁竞争和上下文切换,进而增加开销。

- 性能瓶颈:由于上下文切换的开销和 GIL 的限制,Python 的多线程在处理 CPU 密集型任务时往往不如多进程高效。

-

减少上下文开销的建议

- 使用协程:

- 对于 I/O 密集型任务,使用

asyncio库实现协程可以减少上下文切换开销。

- 对于 I/O 密集型任务,使用

- 使用多进程:

- 对于 CPU 密集型任务,使用

multiprocessing模块创建多个进程,每个进程有自己的 GIL,可以充分利用多核 CPU,减少线程上下文切换开销。

- 对于 CPU 密集型任务,使用

- 批处理任务:

- 尽量减少频繁的线程切换,可以通过批处理任务或增加任务粒度来减小线程切换的频率。

- 使用高效的并发库:

- 例如使用

concurrent.futures提供的线程池或进程池,可以更高效地管理线程和进程,减少上下文切换的开销。

- 例如使用

- 使用协程:

-

总结

线程上下文开销包括保存和恢复线程状态、内存页切换、内核调度、缓存无效化等。在 Python 中,由于 GIL 的存在,线程上下文开销在多线程编程中特别明显。通过使用协程、多进程或高效的并发库,可以减少上下文切换开销,提高程序的并发性能。

乐观锁和悲观锁

-

悲观锁(Pessimistic Locking)

-

简介:

悲观锁假定在访问共享资源时总会发生冲突,因此在操作资源之前,先对资源进行加锁,以确保独占访问。悲观锁会在操作完成后解锁,因此在锁持有期间,其他线程或进程无法访问该资源。

-

特点:

- 阻塞:其他线程在等待锁释放时会被阻塞。

- 开销大:频繁的锁操作会带来性能开销。

- 适用场景:适用于冲突较多或冲突代价较大的场景。

-

示例:使用 Python 的

threading.Lock1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17import threading

lock = threading.Lock()

def critical_section():

with lock:

# 资源操作,确保在加锁期间独占访问

print("Resource is being accessed")

threads = [threading.Thread(target=critical_section) for _ in range(5)]

for t in threads:

t.start()

for t in threads:

t.join()

-

-

乐观锁(Optimistic Locking)

-

简介:

乐观锁假定在访问共享资源时很少发生冲突,因此不在操作之前加锁,而是在提交操作时检查资源是否被修改。如果资源没有冲突,则提交成功;如果资源已经被其他线程修改,则操作失败,需要重新尝试。

-

特点:

- 非阻塞:线程在操作资源时不阻塞其他线程。

- 重试机制:在提交操作时检测冲突,如果冲突则重试。

- 适用场景:适用于冲突较少的场景,减少锁的开销。

-

示例:使用版本号的简单乐观锁实现

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36class OptimisticLock:

def __init__(self):

self.value = 0

self.version = 0

def read(self):

return self.value, self.version

def write(self, new_value, version):

if self.version == version:

self.value = new_value

self.version += 1

return True

return False

optimistic_lock = OptimisticLock()

def worker():

while True:

value, version = optimistic_lock.read()

new_value = value + 1 # 业务逻辑

if optimistic_lock.write(new_value, version):

break # 写成功则退出循环

# 否则重试

threads = [threading.Thread(target=worker) for _ in range(5)]

for t in threads:

t.start()

for t in threads:

t.join()

print(f"Final value: {optimistic_lock.value}")

-

-

比较

- 冲突处理:

- 悲观锁:通过阻塞其他线程来避免冲突,性能开销大,但确保了资源的完整性。

- 乐观锁:通过检测冲突并重试来解决冲突,适用于冲突少的场景。

- 性能:

- 悲观锁:频繁的加锁和解锁操作会带来性能开销。

- 乐观锁:减少了锁的使用,性能较好,但在高冲突情况下,重试机制可能导致性能下降。

- 适用场景:

- 悲观锁:适用于高冲突、高代价的场景,如数据库修改、文件操作等。

- 乐观锁:适用于低冲突、并发访问频繁的场景,如缓存更新等。

- 冲突处理:

-

总结

悲观锁和乐观锁是两种不同的并发控制机制。悲观锁通过阻塞其他线程来避免冲突,适用于高冲突场景;乐观锁通过检测冲突并重试来解决冲突,适用于低冲突场景。根据具体需求选择适当的锁机制,可以有效提高程序的并发性能和资源利用率。

Python 中常用的线程锁?

-

threading.Lockthreading.Lock是最基础的锁类型,通常也被称为互斥锁(mutex)。它用于确保某一时刻只有一个线程可以访问共享资源。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17import threading

lock = threading.Lock()

def critical_section():

with lock:

# 资源操作,确保在加锁期间独占访问

print("Resource is being accessed")

threads = [threading.Thread(target=critical_section) for _ in range(5)]

for t in threads:

t.start()

for t in threads:

t.join() -

threading.RLockthreading.RLock是可重入锁。它允许同一线程在持有锁的情况下再次获得锁,而不会造成死锁。这在递归函数或需要多次获取锁的情况下非常有用。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17import threading

rlock = threading.RLock()

def recursive_function(n):

if n > 0:

with rlock:

print(f"Acquiring lock, recursion depth: {n}")

recursive_function(n - 1)

print(f"Releasing lock, recursion depth: {n}")

thread = threading.Thread(target=recursive_function, args=(3,))

thread.start()

thread.join() -

threading.Conditionthreading.Condition是条件锁。用于复杂的线程间通信。它是更高级的同步原语,可以让线程等待特定的条件状态,然后再继续执行。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31import threading

condition = threading.Condition()

shared_data = []

def consumer():

with condition:

while not shared_data:

condition.wait() # 等待生产者发出信号

item = shared_data.pop()

print(f"Consumed: {item}")

def producer():

with condition:

shared_data.append(1)

print("Produced: 1")

condition.notify() # 通知消费者

threads = [

threading.Thread(target=consumer),

threading.Thread(target=producer)

]

for t in threads:

t.start()

for t in threads:

t.join() -

threading.Semaphorethreading.Semaphore是信号量锁。用于控制对资源的访问,允许多个线程同时访问,但限制最大访问数量。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19import threading

semaphore = threading.Semaphore(3) # 允许最多3个线程同时访问

def worker():

with semaphore:

print(f"{threading.current_thread().name} is working")

# 模拟工作

import time

time.sleep(1)

threads = [threading.Thread(target=worker) for _ in range(5)]

for t in threads:

t.start()

for t in threads:

t.join() -

threading.Eventthreading.Event是一种简单的线程间通信机制,通常用于一个线程等待另一个线程发送信号。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28import threading

event = threading.Event()

def waiter():

print("Waiting for event to be set")

event.wait() # 等待事件信号

print("Event is set, proceeding")

def setter():

import time

time.sleep(2)

print("Setting event")

event.set() # 发送事件信号

threads = [

threading.Thread(target=waiter),

threading.Thread(target=setter)

]

for t in threads:

t.start()

for t in threads:

t.join() -

threading.Barrierthreading.Barrier是屏障锁。用于让指定数量的线程都达到某个点后再继续执行。适用于需要线程同步的场景。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17import threading

barrier = threading.Barrier(3)

def worker():

print(f"{threading.current_thread().name} is waiting at the barrier")

barrier.wait() # 等待所有线程到达屏障

print(f"{threading.current_thread().name} passed the barrier")

threads = [threading.Thread(target=worker) for _ in range(3)]

for t in threads:

t.start()

for t in threads:

t.join()

Python 中线程之间如何通信?

-

概述

在 Python 中,线程之间的通信是多线程编程中的一个重要方面。Python 提供了多种机制和同步原语来实现线程间通信,以确保数据的一致性和线程的协调。这些机制主要包括队列、事件、条件变量、信号量和共享数据结构等。

-

使用

queue.Queuequeue.Queue是一个线程安全的队列,可以用于线程之间的通信。它提供了先进先出 (FIFO)、先进后出 (LIFO) 和优先队列等多种队列类型。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34import threading

import queue

# 创建一个队列对象

q = queue.Queue()

def producer():

for i in range(5):

item = f"item {i}"

q.put(item)

print(f"Produced: {item}")

def consumer():

while True:

item = q.get() # 从队列中取出一个项目

if item is None:

break

print(f"Consumed: {item}")

q.task_done() # 标记任务完成

# 创建并启动线程

producer_thread = threading.Thread(target=producer)

consumer_thread = threading.Thread(target=consumer)

producer_thread.start()

consumer_thread.start()

producer_thread.join()

q.put(None) # 向队列发送停止信号

consumer_thread.join() -

使用

threading.Eventthreading.Event用于线程间的简单信号通信。一个线程可以等待事件发生(等待信号),另一个线程可以设置事件(发送信号)。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27import threading

import time

event = threading.Event()

def worker():

print("Worker is waiting for the event to be set")

event.wait() # 等待事件被设置

print("Event is set, worker proceeding")

def setter():

time.sleep(2)

print("Setter is setting the event")

event.set() # 设置事件

worker_thread = threading.Thread(target=worker)

setter_thread = threading.Thread(target=setter)

worker_thread.start()

setter_thread.start()

worker_thread.join()

setter_thread.join() -

使用

threading.Conditionthreading.Condition提供了更复杂的线程间通信方法,允许多个线程等待某个条件并在条件满足时被唤醒。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30import threading

condition = threading.Condition()

shared_data = []

def consumer():

with condition:

while not shared_data:

condition.wait() # 等待生产者发出信号

item = shared_data.pop()

print(f"Consumed: {item}")

def producer():

with condition:

shared_data.append(1)

print("Produced: 1")

condition.notify() # 通知消费者

consumer_thread = threading.Thread(target=consumer)

producer_thread = threading.Thread(target=producer)

consumer_thread.start()

producer_thread.start()

consumer_thread.join()

producer_thread.join() -

使用

threading.Semaphorethreading.Semaphore可以用于控制对资源的访问,允许多个线程同时访问,但限制最大访问数量。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18import threading

semaphore = threading.Semaphore(3) # 允许最多3个线程同时访问

def worker():

with semaphore:

print(f"{threading.current_thread().name} is working")

import time

time.sleep(1)

threads = [threading.Thread(target=worker) for _ in range(5)]

for t in threads:

t.start()

for t in threads:

t.join() -

使用共享数据结构

线程之间可以通过共享数据结构(例如全局变量、列表、字典等)进行通信,但需要使用锁(如

threading.Lock或threading.RLock)来确保数据的一致性和线程安全。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33import threading

shared_data = []

lock = threading.Lock()

def producer():

for i in range(5):

with lock:

shared_data.append(i)

print(f"Produced: {i}")

def consumer():

while True:

with lock:

if shared_data:

item = shared_data.pop(0)

print(f"Consumed: {item}")

else:

break

producer_thread = threading.Thread(target=producer)

consumer_thread = threading.Thread(target=consumer)

producer_thread.start()

consumer_thread.start()

producer_thread.join()

consumer_thread.join()

Python 爬虫

Scrapy 的工作原理

-

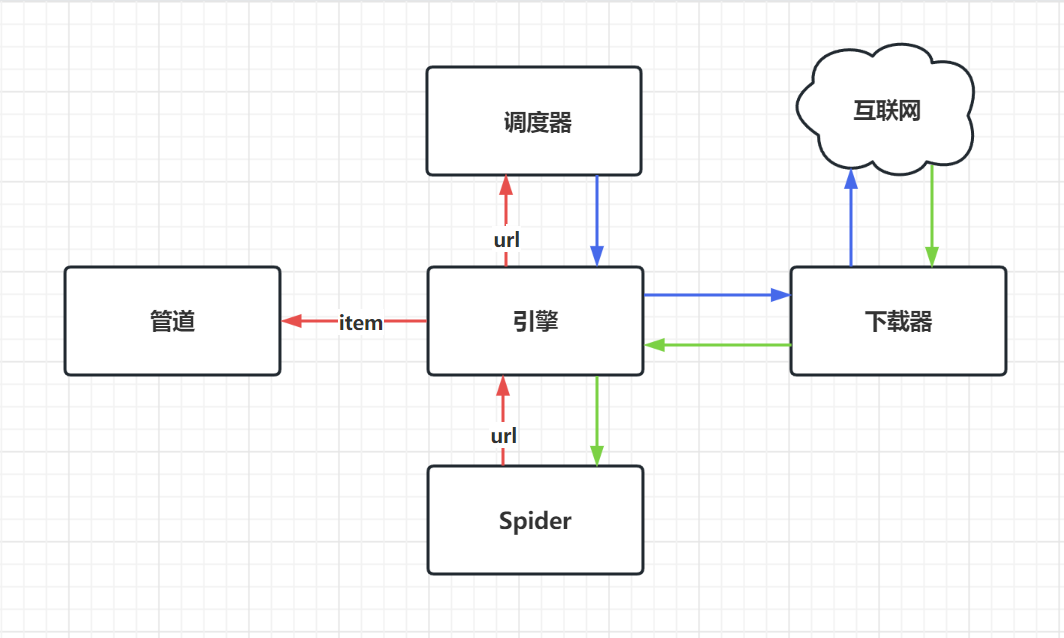

工作原理图

![]()

-

Scrapy 工作流程

- 初始请求:

- Scrapy 引擎从 Spider 中获取初始 URL 请求。

- 调度器接收这些请求并将其排列。

- 请求调度:

- 引擎从调度器中获取一个请求,并将其发送给下载器。

- 下载网页:

- 下载器负责抓取网页内容,并将响应发送给引擎。

- 响应处理:

- 引擎接收下载器的响应,并将其发送给相应的 Spider 处理。

- Spider 解析响应,从中提取数据(Items)或新的请求。

- 生成 Items 和新的请求:

- Spider 生成的数据(Items)被发送到管道(Item Pipeline)进行处理。

- Spider 生成的新请求被发送到调度器,进行下一轮的抓取。

- Items 处理:

- 管道(Item Pipeline)逐步处理数据(Items),最终将其存储在数据库中或其他持久化存储中。

- 初始请求:

Scrapy-Redis 的工作原理

-

概述

Scrapy-Redis 是 Scrapy 框架的一个扩展,旨在使 Scrapy 能够使用 Redis 数据库,实现分布式爬虫。Scrapy-Redis 利用 Redis 来管理任务队列和数据存储,使多个 Scrapy 实例能够协同工作,提高爬虫效率和稳定性。

-

工作流程

- 初始化:

- 爬虫启动时,调度器从 Redis 队列中读取初始请求。

- 如果队列为空,可以配置爬虫从预定义的

start_urls列表中获取初始请求。

- 请求调度:

- 调度器将请求传递给下载器,下载器获取网页内容。

- 下载器将响应返回给引擎,然后交给爬虫处理。

- 响应处理:

RedisSpider解析响应内容,提取数据(Items)并生成新的请求。- 新的请求被推入 Redis 请求队列,等待调度器处理。

- 数据处理:

- 提取的数据通过 Item Pipeline 进行处理和存储,可以将数据直接存入 Redis,或配置其他存储方式。

- 初始化:

Scrapy-Redis 的优缺点

-

优点

- 分布式爬取:

- 通过 Redis 共享任务队列和去重集合,多个爬虫实例可以协同工作,实现高效的分布式爬取。

- 高可扩展性:

- 可以轻松添加更多爬虫实例,无需对代码进行大幅修改,从而快速扩展爬取规模。

- 任务持久化:

- 爬取任务持久化存储在 Redis 中,即使爬虫崩溃或重启,任务也不会丢失,能够继续从上次中断的地方抓取。

- 数据共享:

- 爬虫之间通过 Redis 共享去重集合,确保每个 URL 只被抓取一次,避免重复抓取。

- 灵活的数据存储:

- 支持将抓取数据直接存储在 Redis 中,方便后续数据处理和分析,也可以配置其他数据存储方式。

- 简化的去重机制:

- 使用 Redis 集合进行去重处理,简化了去重逻辑,提高了去重的效率和准确性。

- 分布式爬取:

-

缺点

- 依赖 Redis:

- 需要安装和配置 Redis 服务器,增加了部署和维护的复杂性。

- 对 Redis 的高可用性和性能要求较高,可能需要配置 Redis 集群进行负载均衡。

- 网络开销:

- 爬虫实例和 Redis 之间频繁通信,如果网络环境不好或 Redis 服务器负载过高,可能会影响爬虫性能。

- 单点故障:

- 如果 Redis 服务器出现故障,整个分布式爬虫系统将无法正常工作,除非配置了高可用的 Redis 集群。

- 较高的学习成本:

- 对于初学者而言,配置和调试 Scrapy-Redis 可能较为复杂,需要一定的学习成本和经验积累。

- 性能瓶颈:

- 在高并发情况下,Redis 的性能可能成为瓶颈,需要优化 Redis 配置或采用分片和集群方案。

- 依赖 Redis:

-

总结

Scrapy-Redis 是一个强大的分布式爬虫框架,适合需要大规模并行抓取的场景。它通过 Redis 实现了任务队列和去重的分布式处理,极大地提升了爬虫的效率和可扩展性。然而,Scrapy-Redis 也有其缺点,特别是在部署和维护方面需要一定的经验和技巧。因此,在选择使用 Scrapy-Redis 时,需要根据具体需求和技术能力进行评估和权衡。

Feapder 和 Scrapy 有什么区别?

-

设计理念

- Scrapy:

- 设计简洁,注重模块化和可扩展性。

- 强调复用性和灵活性,提供丰富的中间件和扩展机制。

- 社区活跃,拥有丰富的文档和第三方扩展。

- Feapder:

- 目标是提供更高效、易用且功能丰富的爬虫框架。

- 注重分布式爬取、高效的数据存储和处理,以及灵活的任务调度。

- 更加关注大规模数据抓取和处理的场景。

- Scrapy:

-

任务调度和分布式支持

- Scrapy:

- 默认情况下是单机爬取,但可以通过 Scrapy-Redis 等扩展实现分布式爬取。

- 调度器和去重机制可以通过配置和扩展进行定制。

- Feapder:

- 原生支持分布式爬取,任务调度和队列管理更加高效。

- 支持任务的持久化存储、重试和优先级处理,确保任务不会丢失或遗漏。

- Scrapy:

-

数据存储与处理

- Scrapy:

- 提供灵活的 Item Pipeline,可以将爬取的数据存储到各种后端,如数据库、文件系统等。

- 通过中间件和扩展可以实现复杂的数据处理逻辑。

- Feapder:

- 更加关注数据的高效存储和处理,支持多种数据存储方式,如数据库、文件系统和消息队列。

- 支持数据的清洗、验证和异步处理,方便与其他系统进行集成。

- Scrapy:

-

易用性和学习成本

- Scrapy:

- API 设计简洁,文档和社区资源丰富,便于初学者快速上手。

- 拥有丰富的示例和教程,遇到问题时可以找到大量参考资料。

- Feapder:

- API 设计同样简洁,但在某些高级功能上可能需要更多的自主学习和探索。

- 文档和社区资源相对较少,可能需要更多的时间进行调试和问题解决。

- Scrapy:

-

扩展性和生态系统

- Scrapy:

- 拥有丰富的中间件和第三方扩展,生态系统非常活跃。

- 可以通过扩展快速实现复杂功能,如分布式爬取、代理池管理等。

- Feapder:

- 扩展性同样优秀,但第三方扩展和插件较少,某些特定功能可能需要自行开发。

- 适合需要高度定制化、且有一定开发能力的团队或个人。

- Scrapy:

-

实际案例

- Scrapy:

- 适用于一般的网页抓取任务、小规模数据抓取和个人项目。

- 常用于数据采集、内容监控和网页数据挖掘等场景。

- Feapder:

- 适用于大规模数据抓取和处理、需要分布式爬取的场景。

- 常用于大数据分析、商业情报采集和复杂的网页抓取任务。

- Scrapy:

-

总结

- Scrapy 是一个功能强大且成熟的爬虫框架,适用于多数网页抓取任务,特别是需要快速上手和复用现有资源的场景。

- Feapder 更加注重大规模数据抓取和分布式处理,适合需要高效、稳定的爬虫系统的场景,尤其是在数据量大、任务复杂的情况下。

爬虫爬取数据的过程中,遇到的反爬手段及解决方案

-

User-Agent 检测

- 反爬手段: 网站通过检测请求头中的 User-Agent 字段来判断请求是否来自于正常的浏览器。

- 解决方案:

- 随机化 User-Agent 字段,使用不同的浏览器标识。

- 可以使用

fake_useragent库来生成随机的 User-Agent。1

2

3

4

5

6

7from fake_useragent import UserAgent

ua = UserAgent()

headers = {

'User-Agent': ua.random,

}

-

IP 封禁

- 反爬手段: 网站通过限制单个 IP 的请求频率来防止过度抓取。

- 解决方案:

- 使用代理池,通过不同的代理 IP 发送请求。

- 使用

requests或scrapy配置代理。1

2

3

4

5

6proxies = {

'http': 'http://10.10.1.10:3128',

'https': 'http://10.10.1.11:1080',

}

response = requests.get(url, proxies=proxies)

-

Cookies 和会话

- 反爬手段: 网站使用 Cookies 和会话来跟踪用户,并阻止非正常的访问。

- 解决方案:

- 模拟持久化的会话,保持登录状态。

- 使用

requests.Session或scrapy的CookieMiddleware来管理会话。1

2

3session = requests.Session()

response = session.get(url)

-

验证码

- 反爬手段: 网站使用验证码来防止自动化工具的访问。

- 解决方案:

- 人工解决:手动输入验证码。

- 技术解决:使用 OCR 技术自动识别验证码(如

tesseract-ocr)。1

2

3

4

5from PIL import Image

import pytesseract

captcha_text = pytesseract.image_to_string(Image.open('captcha.png')) - 服务解决:使用第三方打码服务。

-

动态内容加载

- 反爬手段: 网站使用 JavaScript 动态加载内容,普通的 HTTP 请求无法获取完整内容。

- 解决方案:

- 使用无头浏览器(如 Selenium、Puppeteer)来渲染页面并抓取内容。

1

2

3

4

5

6from selenium import webdriver

browser = webdriver.Chrome()

browser.get(url)

html = browser.page_source - 使用网络请求分析工具(如 Fiddler、Chrome DevTools)查看实际的数据接口,然后直接请求该接口。

- 使用无头浏览器(如 Selenium、Puppeteer)来渲染页面并抓取内容。

-

请求频率限制

- 反爬手段: 网站通过检测请求频率来防止过度抓取。

- 解决方案:

- 实现请求间隔控制,添加随机的延迟。

1

2

3

4

5import time

import random

time.sleep(random.uniform(1, 3)) - 使用

scrapy的DOWNLOAD_DELAY或AutoThrottle组件。

- 实现请求间隔控制,添加随机的延迟。

-

复杂的请求头验证

- 反爬手段: 网站通过检查请求头的复杂组合来检测非正常访问。

- 解决方案:

- 模拟真实浏览器请求头,添加常见的字段(如

Referer、Accept-Language)。1

2

3

4

5

6

7headers = {

'User-Agent': ua.random,

'Referer': 'https://example.com',

'Accept-Language': 'en-US,en;q=0.9',

}

response = requests.get(url, headers=headers) - 使用浏览器开发者工具查看实际请求头,并在爬虫中进行模拟。

- 模拟真实浏览器请求头,添加常见的字段(如

-

内容混淆和加密

- 反爬手段: 网站使用 JavaScript 对内容进行混淆或加密,防止直接解析 HTML。

- 解决方案:

- 分析 JavaScript 代码,逆向解密算法。

- 使用浏览器自动化工具(如 Selenium)来执行 JavaScript 并获取解密后的内容。

1

2

3

4

5

6from selenium import webdriver

browser = webdriver.Chrome()

browser.get(url)

html = browser.page_source

-

数据格式变化

- 反爬手段: 网站频繁更改数据格式或结构,防止爬虫稳定运行。

- 解决方案:

- 使用 XPath 或 CSS 选择器来定位数据,减少对具体结构的依赖。

- 定期维护爬虫代码,及时更新解析逻辑。

-

动态 IP 监控

- 反爬手段: 网站通过监控多个 IP 的行为,检测高度相似的请求模式。

- 解决方案:

- 随机化请求的顺序和频率,模拟真实用户行为。

- 结合代理池和分布式爬取,降低单个 IP 的请求频率。

如果对方网站可以反爬取,封 ip 怎么办?

-

使用代理池

利用代理池可以实现从不同的 IP 地址发送请求,从而避免单个 IP 被封禁。在 Python 中,可以使用

requests库结合代理池来实现这一点。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23import requests

from itertools import cycle

# 定义代理池

proxies = [

'http://10.10.1.10:3128',

'http://10.10.1.11:1080',

'http://10.10.1.12:3128',

# 其他代理地址...

]

proxy_pool = cycle(proxies)

# 使用代理池发送请求

url = 'https://example.com'

for i in range(10):

proxy = next(proxy_pool)

try:

response = requests.get(url, proxies={"http": proxy, "https": proxy})

print(response.text)

except requests.exceptions.RequestException as e:

print(f"Error with proxy {proxy}: {e}") -

使用代理服务

使用商业代理服务,如 Luminati、Bright Data、Oxylabs 等,这些服务提供高质量的代理 IP,通常具备较高的稳定性和匿名性。

1

2

3

4

5

6

7

8import requests

proxy = 'http://user:password@proxy-service.com:port'

url = 'https://example.com'

response = requests.get(url, proxies={"http": proxy, "https": proxy})

print(response.text) -

动态 IP 拨号

在本地或云服务器上通过拨号实现动态 IP 更换。可以使用 VPN 服务或设备重启来获取新的 IP 地址。

注意事项:

- 需要具备相应的网络环境和硬件条件。

- 这种方法可能需要手动或编程实现动态 IP 更换。

-

控制请求频率

通过降低请求频率和随机化请求间隔,减少被封禁的概率。可以在请求之间添加一定的延迟,模拟正常用户的行为。

1

2

3

4

5

6

7

8

9

10import time

import random

import requests

url = 'https://example.com'

for i in range(10):

response = requests.get(url)

print(response.text)

time.sleep(random.uniform(1, 3)) # 随机延迟 1-3 秒 -

分布式爬取

使用多个机器或云服务器进行分布式爬取,每个机器使用不同的 IP 地址和代理,从而降低单个 IP 被封禁的风险。

工具:

- Scrapy + Scrapy-Redis:实现分布式爬取和去重。

- Celery:分布式任务队列,可以将爬取任务分发到多个工作节点。

-

使用无头浏览器

利用无头浏览器(如 Selenium、Puppeteer)模拟真实的浏览器行为,这样可以绕过部分简单的反爬机制,同时也可以更好地处理 JavaScript 动态加载的内容。

1

2

3

4

5

6

7

8

9

10

11

12

13from selenium import webdriver

options = webdriver.ChromeOptions()

options.add_argument('headless')

browser = webdriver.Chrome(options=options)

url = 'https://example.com'

browser.get(url)

html = browser.page_source

print(html)

browser.quit() -

动态代理替换

定期更换代理,避免单个代理长时间使用导致被封禁。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21import requests

import random

from itertools import cycle

proxies = [

'http://10.10.1.10:3128',

'http://10.10.1.11:1080',

'http://10.10.1.12:3128',

# 其他代理地址...

]

proxy_pool = cycle(proxies)

url = 'https://example.com'

for i in range(10):

proxy = next(proxy_pool)

response = requests.get(url, proxies={"http": proxy, "https": proxy})

print(response.text)

if i % 2 == 0: # 每 2 次请求更换一次代理

proxy = next(proxy_pool) -

模拟真实用户行为

模拟用户的浏览行为,如点击、滚动等操作,尽量让爬虫行为看起来更像真实用户。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18from selenium import webdriver

import time

options = webdriver.ChromeOptions()

options.add_argument('headless')

browser = webdriver.Chrome(options=options)

url = 'https://example.com'

browser.get(url)

time.sleep(2) # 停留一段时间

browser.execute_script('window.scrollTo(0, document.body.scrollHeight);') # 模拟滚动

time.sleep(2)

html = browser.page_source

print(html)

browser.quit()

爬虫滑块验证码解决方法

-

概述

滑块验证码是一种常见的反爬手段,它通过要求用户拖动滑块以完成某种图形匹配,从而确认用户为人类而不是机器人。解决滑块验证码较为复杂,因为它通常涉及图像处理和复杂的交互操作。

-

人工打码

将滑块验证码的截图发送到打码平台,由人工打码来完成验证。这种方法可靠但成本较高。

-

使用第三方打码平台

使用第三方打码平台,如 2Captcha、Anticaptcha 等,这些平台提供 API,可以自动解决滑块验证码。

-

使用无头浏览器模拟用户行为

使用无头浏览器(如 Selenium、Puppeteer)模拟用户拖动滑块的行为。这种方法复杂且不一定能保证成功,但有时会有效。

-

逆向工程和图像处理

通过逆向工程和图像处理技术,自动识别滑块验证码并完成验证。这种方法需要较高的技术水平和大量的开发工作。

步骤:

- 截图和图像处理:截取滑块验证码的图片并进行处理,识别滑块和目标位置。

- 计算位移:根据图像识别结果计算滑块需要移动的距离。

- 模拟拖动:使用无头浏览器或其他工具模拟拖动滑块。

-

使用机器学习

训练机器学习模型识别滑块验证码的图像特征,从而自动解码。这种方法需要大量的数据和相应的技术积累。

Python 基础

Python垃圾回收机制?

-

概述

- Python 的垃圾回收机制主要有以下几种,主要包括引用计数(Reference Counting)和垃圾回收器(Garbage Collector,简称 GC)。垃圾回收器又包含了分代回收机制(Generational Garbage Collection)。

- Python 的垃圾回收机制主要包括引用计数和垃圾回收器,后者基于分代回收机制来有效管理内存。引用计数简单直观,但无法处理循环引用;垃圾回收器通过分代回收机制来高效地回收内存。此外,Python 还提供了一些接口来手动控制垃圾回收的行为。

-

引用计数(Reference Counting)

引用计数是 Python 内存管理的基础机制。每一个对象都会维护一个引用计数器,记录有多少个引用指向该对象。当引用计数变为零时,意味着该对象不再被使用,Python 会立即释放该对象所占用的内存。

-

垃圾回收器(Garbage Collector)

为了处理循环引用的问题,Python 引入了垃圾回收器。Python 的垃圾回收器使用了一种基于分代回收的机制。

-

分代回收机制(Generational Garbage Collection)

Python 将所有对象划分为三代:年轻代(Generation 0)、中代(Generation 1)和老代(Generation 2)。假设年轻的对象更容易被销毁,老的对象更不容易被销毁。

-

-

手动控制垃圾回收

Python 提供了一些接口来手动启用或禁用垃圾回收,以及调整垃圾回收的行为。

1

2

3

4

5

6

7

8

9

10

11

12

13import gc

gc.disable() # 禁用垃圾回收

# 运行一些代码

gc.enable() # 启用垃圾回收

gc.collect() # 手动触发垃圾回收

# 获取当前垃圾回收阈值

print(gc.get_threshold())

# 设置新的垃圾回收阈值

gc.set_threshold(700, 10, 10) -

垃圾回收器的内部机制

垃圾回收器在内部通过追踪对象间的引用关系,构建引用图来检测循环引用。GC 算法的核心是标记-清除(Mark and Sweep)和标记-压缩(Mark and Compact)。Python 的垃圾回收器基于这些基础算法,进行优化和改进。

Python 有哪些数据类型以及彼此间的区别?

| 数据 | 类型 | 值/表示方法 | 区别 |

|---|---|---|---|

| 整型 | int | 不可变 | |

| 浮点型 | float | 不可变 | |

| 布尔型 | bool | true/false | |

| 空 | NoneType | None | |

| 字符串 | str | 有序;可重复 | |

| 列表 | list | [] | 有序;可变;可重复 |

| 元组 | tuple | () | 有序;不可变;可重复 |

| 集合 | set | {} | 无序;不重复 |

| 字典 | dict | { key : value } | 无序;可变 |

深拷贝和浅拷贝的区别?

-

浅拷贝(Shallow Copy)

- 定义:创建一个新对象,但不会递归复制原始对象内部的子对象,而是直接引用子对象的内存地址。

- 特点:

- 新对象和原对象是独立的,但它们的子对象是共享的(修改子对象会影响双方)。

- 适用于不可变子对象(如整数、字符串)或不需要独立子对象的情况。

- 实现方式:

copy.copy()- 列表的切片操作

list.copy()或list[:] - 字典的

dict.copy()

- 示例:

1

2

3

4

5

6

7

8import copy

original = [[1, 2], [3, 4]]

shallow = copy.copy(original)

# 修改浅拷贝的子对象会影响原对象!

shallow[0][0] = 99

print(original) # 输出: [[99, 2], [3, 4]]

-

深拷贝(Deep Copy)

- 定义:创建一个新对象,并递归复制原始对象及其所有子对象,完全独立于原对象。

- 特点:

- 新对象和原对象完全隔离,修改任何一方都不会影响另一方。

- 适用于需要完全独立的副本(尤其是可变子对象如列表、字典)。

- 实现方式:

copy.deepcopy()

- 示例:

1

2

3

4

5

6

7

8import copy

original = [[1, 2], [3, 4]]

deep = copy.deepcopy(original)

# 修改深拷贝的子对象不会影响原对象

deep[0][0] = 99

print(original) # 输出: [[1, 2], [3, 4]]

-

关键区别总结

特性 浅拷贝 深拷贝 复制层级 仅顶层对象 递归复制所有子对象 子对象是否共享 是(修改子对象会影响原对象) 否(完全独立) 性能 更快(不复制子对象) 较慢(需递归复制) 适用场景 子对象不可变或无需独立 子对象可变且需要完全独立副本 -

特殊情况注意

- 不可变对象(如元组、字符串、整数):浅拷贝和深拷贝效果相同(因为它们无法修改)。

- 自定义对象:可通过实现

__copy__()和__deepcopy__()方法控制拷贝行为。

什么是闭包?

-

闭包的定义和行为

- 一个外部函数。

- 在外部函数内部定义的一个或多个内部函数。

- 外部函数返回内部函数,并且内部函数引用了外部函数的变量或参数。

-

闭包的特点

- 变量捕获:内部函数可以捕获并记住其外部函数的变量,即使外部函数已经执行完毕。

- 持久化作用域:闭包使得外部函数的作用域在其返回后依然存在。

-

示例

1

2

3

4

5

6

7

8

9

10

11def outer_function(x):

def inner_function(y):

return x + y

return inner_function

closure = outer_function(10)

result = closure(5) # 15

print(result) -

闭包的应用场景

- 工厂函数:闭包可以用于创建带有特定配置或初始状态的函数。

- 数据隐藏:闭包可以用于实现数据封装和隐藏,保护数据不被外部直接访问和修改。

- 回调和事件处理:闭包可以用于管理回调函数和事件处理,捕获特定上下文中的变量。

- 缓存和记忆化:闭包可以用于实现缓存和记忆化,保存以前计算的结果以提高性能。

-

需要注意的事项

- 内存泄漏:如果闭包捕获了大量变量或占用大量资源,可能导致内存泄漏。

- 性能问题:过度使用闭包可能会引入不必要的复杂性和性能开销。

- 调试困难:闭包中变量的捕获和作用域可能使调试变得更加困难。

什么是装饰器?

-

概述

装饰器(Decorator)是 Python 中一个非常强大的功能,用于在不修改原有函数或方法的情况下,动态地给其增加额外的功能。装饰器本质上是一个函数,它可以接收另一个函数作为参数,并返回一个新的函数。装饰器广泛应用于日志记录、权限检查、性能统计、缓存等场景。

-

示例

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16def my_decorator(func):

def wrapper():

print("Something is happening before the function is called.")

func()

print("Something is happening after the function is called.")

return wrapper

def say_hello():

print("Hello!")

say_hello()

什么是可迭代对象?

-

概述

在 Python 中,可迭代对象(Iterable)是指可以返回一个迭代器的对象。简单来说,可迭代对象是可以逐一访问其元素的对象。常见的可迭代对象包括列表(list)、元组(tuple)、字符串(string)、字典(dictionary)、集合(set)等。一个对象要成为可迭代对象,必须实现

__iter__()方法,或者实现__getitem__()方法并且从索引 0 开始。 -

可迭代对象的定义

- 实现

__iter__()方法:返回一个迭代器对象,该迭代器对象实现了__next__()方法。 - 实现

__getitem__()方法:允许按索引访问其元素,且从索引 0 开始索引。

- 实现

什么是迭代器?

-

概述

在 Python 中,迭代器(Iterator)是一个实现了迭代协议的对象。迭代协议包括

__iter__()方法和__next__()方法。迭代器的主要目的是提供一种访问集合元素的方式,而不需要暴露集合内部的实现细节。迭代器可以被用于for循环、生成器表达式和许多其他需要逐个访问元素的场景。 -

迭代器的定义

__iter__(): 返回迭代器对象自身。这使得迭代器对象也可以用在for循环等上下文中。__next__(): 返回容器的下一个元素,如果没有元素了,则抛出StopIteration异常。

-

迭代器的特性

- 惰性求值: 迭代器一次只计算一个值,这对于处理大数据集或无限序列非常有用。

- 一次性使用: 迭代器一旦遍历完所有元素,就无法重置或重新使用。

可迭代对象与迭代器的区别?

- 迭代器(Iterator):不仅实现了

__iter__()方法,还实现了__next__()方法。 - 可迭代对象(Iterable):只需要实现

__iter__()方法或__getitem__()方法。

什么是生成器?

-

概述

生成器(Generator)是 Python 中的一种特殊类型的迭代器,它使得我们可以使用简单的代码生成复杂的迭代序列。生成器通过定义一个包含

yield表达式的函数来创建。每次调用yield时,函数会生成一个值并暂停其状态,直到下次继续执行。这种特性使得生成器特别适合处理大量数据或无限序列。 -

生成器的特性

- 惰性求值:生成器每次只生成一个值,不会一次性生成所有值。这对于处理大数据集或无限序列非常有用,因为它降低了内存消耗。

- 状态保存:生成器会自动保存上次离开的位置和状态信息,下次从暂停的位置继续执行。

- 一次性使用:生成器一旦遍历完所有元素,就无法重置或重新使用。

-

生成器的创建

- 生成器可以通过生成器函数和生成器表达式这两种方式来创建。

- 生成器函数

生成器函数是包含yield关键字的普通函数。每次调用yield时,函数会生成一个值并暂停其执行,直到下次调用next()时继续执行。1

2

3

4

5

6

7

8

9

10

11

12def my_generator(start, end):

current = start

while current < end:

yield current

current += 1

# 使用生成器函数

gen = my_generator(1, 5)

for num in gen:

print(num) - 生成器表达式

生成器表达式是一种简洁的生成器创建方式,类似于列表推导式,但使用圆括号()。1

2

3

4

5gen = (x * x for x in range(5))

for num in gen:

print(num)

-

生成器与普通函数的区别

- 返回值:普通函数使用

return返回值并终止函数执行,而生成器使用yield暂停执行并返回一个值。 - 状态保存:普通函数在每次调用时都会重新开始执行,而生成器会保存上次离开的状态和位置。

- 返回值:普通函数使用

-

生成器的优点

- 内存效率:生成器不会一次性生成所有值,节省内存。

- 代码简洁:生成器使得编写复杂的迭代逻辑更加简单和直观。

- 惰性求值:生成器可以按需生成值,适合处理流式数据或无限序列。

-

使用生成器的场景

- 处理大数据集:生成器可以逐个处理数据,避免一次性加载大量数据到内存中。

- 流式数据处理:生成器可以按需生成数据,适合处理实时数据流。

- 无限序列:生成器可以用于生成无限序列,例如 Fibonacci 数列等。

什么是单例模式?有哪些实现方法?有哪些使用场景?

-

概述

单例模式(Singleton Pattern)是一种设计模式,其目的是确保一个类在应用程序生命周期中仅有一个实例,并提供一个全局访问点来访问该实例。单例模式通常用于控制对共享资源的访问,比如数据库连接、配置文件、日志记录等。

-

单例模式的实现方法

-

使用类属性

通过类属性来存储单例实例,并在

__new__方法中控制实例的创建。1

2

3

4

5

6

7

8

9

10

11

12

13

14class Singleton:

_instance = None

def __new__(cls, *args, **kwargs):

if cls._instance is None:

cls._instance = super(Singleton, cls).__new__(cls, *args, **kwargs)

return cls._instance

# 使用示例

s1 = Singleton()

s2 = Singleton()

print(s1 is s2) # 输出: True -

使用装饰器

通过装饰器来实现单例模式。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21def singleton(cls):

instances = {}

def get_instance(*args, **kwargs):

if cls not in instances:

instances[cls] = cls(*args, **kwargs)

return instances[cls]

return get_instance

class Singleton:

pass

# 使用示例

s1 = Singleton()

s2 = Singleton()

print(s1 is s2) # 输出: True -

使用元类

通过元类(metaclass)来控制类的实例化过程。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18class SingletonMeta(type):

_instances = {}

def __call__(cls, *args, **kwargs):

if cls not in cls._instances:

cls._instances[cls] = super(SingletonMeta, cls).__call__(*args, **kwargs)

return cls._instances[cls]

class Singleton(metaclass=SingletonMeta):

pass

# 使用示例

s1 = Singleton()

s2 = Singleton()

print(s1 is s2) # 输出: True

-

-

单例模式的使用场景

- 日志记录:通常需要一个全局的日志记录对象,以便于在应用程序的各个部分进行统一的日志记录。

- 配置管理:在应用程序中,配置文件通常只有一个实例,用于存储全局配置。

- 数据库连接:对于数据库连接池或数据库引擎实例,通常需要确保只有一个实例,以便共享连接资源。

- 线程池:在多线程环境中,线程池通常只有一个实例,以便于管理和分配线程资源。

- 缓存:在需要全局缓存的数据时,使用单例模式可以确保缓存实例的唯一性。

-

注意事项

虽然单例模式在某些场景下非常有用,但也需要谨慎使用。滥用单例模式可能会导致代码难以测试和维护,因为全局的单例实例会增加代码的耦合性。此外,单例模式还可能导致多线程环境下的竞态条件,需要小心处理并发问题。

hashlib 加密后的内容分别有几位?

在Python中,hashlib模块提供了多种哈希算法用于生成固定长度的哈希值。这些哈希算法包括常见的MD5、SHA-1、SHA-224、SHA-256、SHA-384、SHA-512等。每种哈希算法生成的哈希值长度是固定的,具体长度如下:

| 哈希算法 | 哈希值位数(字符数) | 哈希值字节数 |

|---|---|---|

| MD5 | 32 | 16 |

| SHA-1 | 40 | 20 |

| SHA-224 | 56 | 28 |

| SHA-256 | 64 | 32 |

| SHA-384 | 96 | 48 |

| SHA-512 | 128 | 64 |

1 | import hashlib |

列表和元组有什么区别?

- 列表:可变,使用方括号([]),适合需要频繁修改数据的场景,性能可能会稍微差一些,特别是当列表很大时。

- 元组:不可变,使用小括号(()),适合不需要修改的数据,或者需要作为字典键的场景,在某些情况下比列表更高效。

Python 中 append,insert 和 extend 的区别?

-

append()append方法用于在列表的末尾追加一个元素。它只接受一个参数,该参数可以是任何类型的对象(数字、字符串、列表等)。 -

insert()insert方法用于在列表的指定位置插入一个元素。它接受两个参数:第一个参数是插入的位置索引,第二个参数是要插入的元素。 -

extend()extend方法用于将另一个可迭代对象(如列表、元组、字符串等)的所有元素添加到当前列表的末尾。它接受一个参数,该参数必须是一个可迭代对象。

break、continue、pass 是什么?

-

breakbreak语句用于终止循环(for或while)。当break语句被执行时,循环立即结束,程序控制流继续执行循环之后的代码。 -

continuecontinue语句用于跳过当前循环的剩余代码,直接进入下一次循环迭代。它会终止当前迭代的剩余语句并回到循环的开始。 -

passpass语句是一个空操作,占位符。它什么也不做,但可以用在需要一个语句而实际没有具体操作的场合。pass语句通常用于编写占位代码,以便稍后填充实际实现。

区分 Python 中的 remove、del 和 pop?

-

remove()remove方法用于删除列表中第一个匹配的指定值。如果该值在列表中不存在,会引发ValueError异常。1

2

3

4

5

6

7my_list = [1, 2, 3, 2, 4]

my_list.remove(2)

print(my_list) # 输出: [1, 3, 2, 4]

# 元素不存在时会报错

# my_list.remove(5) # ValueError: list.remove(x): x not in list -

deldel语句用于删除列表中指定位置的元素或整个列表。与remove和pop不同,del不是列表的方法,而是 Python 的一个语句,可以删除任何对象,但常用于删除列表中的元素。1

2

3

4

5

6

7

8

9

10

11

12my_list = [1, 2, 3, 4]

del my_list[1]

print(my_list) # 输出: [1, 3, 4]

# 删除一个切片

del my_list[1:3]

print(my_list) # 输出: [1]

# 删除整个列表

del my_list

# print(my_list) # NameError: name 'my_list' is not defined -

pop()pop方法用于删除列表中指定位置的元素,并返回该元素。默认情况下,它删除并返回列表的最后一个元素。如果指定了索引,则删除该索引位置的元素并返回。1

2

3

4

5

6

7

8

9

10

11

12

13my_list = [1, 2, 3, 4]

element = my_list.pop()

print(element) # 输出: 4

print(my_list) # 输出: [1, 2, 3]

# 删除并返回指定位置的元素

element = my_list.pop(1)

print(element) # 输出: 2

print(my_list) # 输出: [1, 3]

# 索引超出范围时会报错

# my_list.pop(5) # IndexError: pop index out of range

== 和 is 的区别是?

-

==运算符==运算符用于比较两个对象的值是否相等。换句话说,它检查两个对象在内容上是否相等。1

2

3

4

5

6

7a = [1, 2, 3]

b = [1, 2, 3]

c = a

print(a == b) # 输出: True

print(a == c) # 输出: True -

is运算符is运算符用于比较两个对象的身份,即它们是否是同一个对象。它检查两个对象在内存中的地址是否相同。1

2

3

4

5

6

7a = [1, 2, 3]

b = [1, 2, 3]

c = a

print(a is b) # 输出: False

print(a is c) # 输出: True

如何更改列表的数据类型?

-

使用列表推导式

列表推导式是一种简洁且高效的方法,用于创建和转换列表。可以通过列表推导式将列表中的每个元素转换为所需的数据类型。

1

2

3

4

5

6

7

8

9

10# 将字符串列表转换为整数列表

str_list = ['1', '2', '3', '4']

int_list = [int(x) for x in str_list]

print(int_list) # 输出: [1, 2, 3, 4]

# 将整数列表转换为字符串列表

int_list = [1, 2, 3, 4]

str_list = [str(x) for x in int_list]

print(str_list) # 输出: ['1', '2', '3', '4'] -

使用

map函数map函数适用于将一个函数应用于一个或多个序列中的每一个元素,并返回一个迭代器。可以使用list函数将返回的迭代器转换为列表。1

2

3

4

5

6

7

8

9

10# 将字符串列表转换为整数列表

str_list = ['1', '2', '3', '4']

int_list = list(map(int, str_list))

print(int_list) # 输出: [1, 2, 3, 4]

# 将整数列表转换为字符串列表

int_list = [1, 2, 3, 4]

str_list = list(map(str, int_list))

print(str_list) # 输出: ['1', '2', '3', '4'] -

使用循环

可以使用循环遍历列表并手动转换每个元素的数据类型。

1

2

3

4

5

6

7

8

9

10

11

12

13

14# 将字符串列表转换为整数列表

str_list = ['1', '2', '3', '4']

int_list = []

for x in str_list:

int_list.append(int(x))

print(int_list) # 输出: [1, 2, 3, 4]

# 将整数列表转换为字符串列表

int_list = [1, 2, 3, 4]

str_list = []

for x in int_list:

str_list.append(str(x))

print(str_list) # 输出: ['1', '2', '3', '4'] -

使用

numpy数组(适用于数值数据)如果列表中元素都是数值数据,可以使用

numpy库进行高效的数据类型转换。1

2

3

4

5

6

7

8import numpy as np

# 将整数列表转换为浮点数列表

int_list = [1, 2, 3, 4]

float_array = np.array(int_list, dtype=float)

float_list = float_array.tolist()

print(float_list) # 输出: [1.0, 2.0, 3.0, 4.0]

什么是 lambda 函数?

-

概述

lambda函数,也称为匿名函数,是一种在 Python 中用于创建小型、单行函数的简洁方法。与常规的使用def关键字定义的函数不同,lambda函数没有名字,通常用于需要一个简单函数但不想正式定义一个函数的场景。 -

语法

lambda函数的基本语法如下:1

lambda 参数1, 参数2, ... : 表达式

lambda关键字引导。- 后跟一个或多个用逗号分隔的参数。

- 冒号

:分隔参数和表达式。 - 表达式是计算并返回的内容。

-

示例

1

2

3

4# 定义一个 lambda 函数,计算两个数的和

add = lambda x, y: x + y

print(add(3, 5)) # 输出: 8

解释 Python 中的 Map 函数?

-

概述

map函数是 Python 的一个内置函数,用于将一个指定的函数应用到一个或多个序列(如列表、元组等)的每一个元素,并返回一个迭代器,包含应用函数后的结果。map函数对于需要对序列中的每个元素进行相同操作的场景非常有用。 -

语法

1

map(function, iterable, ...)

function:一个函数对象,map会将此函数应用到给定的iterable的每一个元素。iterable:一个或多个序列(如列表、元组、字符串等)。

-

示例

1

2

3

4numbers = [1, 2, 3, 4, 5]

squared_numbers = map(lambda x: x ** 2, numbers)

print(list(squared_numbers)) # 输出: [1, 4, 9, 16, 25]

解释 Python 中的 Filter 函数?

-

概述

filter函数是 Python 的一个内置函数,用于筛选序列中的元素。它接受一个函数和一个可迭代对象(如列表、元组、字符串等),并返回一个迭代器,包含所有使该函数返回True的元素。 -

语法

1

filter(function, iterable)

function:一个函数对象,用于测试可迭代对象中的每个元素。该函数应返回布尔值True或False。iterable:一个可迭代对象(如列表、元组、字符串等),其元素将被逐一传递给function。

-

示例

1

2

3

4numbers = [1, 2, 3, 4, 5, 6, 7, 8, 9, 10]

even_numbers = filter(lambda x: x % 2 == 0, numbers)

print(list(even_numbers)) # 输出: [2, 4, 6, 8, 10]

解释 Python 中 reduce 函数?

-

概述

reduce函数是 Python 中functools模块提供的一个函数,用于对序列中的元素进行累积操作。与map和filter不同,reduce函数会将序列中的元素逐步聚合为一个单一的结果。 -

语法

1

2

3

4from functools import reduce

reduce(function, iterable[, initializer])function:一个二元函数,即接受两个参数的函数。reduce会将此函数应用于可迭代对象的元素。iterable:一个可迭代对象(如列表、元组等),其元素将被逐一传递给function。initializer(可选):一个初始值。如果提供,它将作为计算的初始值,并与可迭代对象的第一个元素一同传递给function。

-

工作原理

reduce函数从可迭代对象的第一个元素开始,将前两个元素传递给function,然后将结果与第三个元素一起传递给function,以此类推,直到处理完所有元素。最终的结果是单一的聚合值。 -

示例

1

2

3

4

5

6

7

8

9

10from functools import reduce

numbers = [1, 2, 3, 4, 5]

result = reduce(lambda x, y: x + y, numbers)

print(result) # 输出: 15

numbers = [1, 2, 3, 4, 5]

result = reduce(lambda x, y: x + y, numbers, 10)

print(result) # 输出: 25

解释 Python 中的 pickling 和 unpickling?

-

概述

在 Python 中,pickling 和 unpickling 是用于对象序列化和反序列化的过程。这两个术语源自 Python 的

pickle模块,该模块提供了这些功能。 -

Pickling(序列化)

Pickling 是将 Python 对象(如列表、字典、类实例等)转换为字节流的过程。这个字节流可以被存储在文件中,通过网络传输,或者用于其他需要持久化或传输对象的场景。

1

2

3

4

5

6

7

8

9

10

11

12import pickle

data = {

'name': 'Alice',

'age': 30,

'scores': [85, 90, 92]

}

# 序列化对象到文件

with open('data.pkl', 'wb') as file:

pickle.dump(data, file) -

Unpickling(反序列化)

Unpickling 是将字节流转换回 Python 对象的过程。这个过程与 pickling 相反,可以从文件中读取字节流,或者从网络接收字节流,然后将其转换回原始的 Python 对象。

1

2

3

4

5

6

7

8import pickle

# 从文件反序列化对象

with open('data.pkl', 'rb') as file:

data = pickle.load(file)

print(data) # 输出: {'name': 'Alice', 'age': 30, 'scores': [85, 90, 92]} -

注意事项

- 安全性:Unpickling 可能会执行任意代码,因此在使用

pickle模块时需要格外小心。不要 unpickle 来自不可信或未经验证的源的数据。 - 兼容性:不同版本的 Python 可能会有不同的

pickle协议,因此在不同版本的 Python 之间共享 pickle 文件时需要注意兼容性问题。 - 性能:Pickling 和 unpickling 可能会引入性能开销,特别是对于大型或复杂的数据结构。

- 安全性:Unpickling 可能会执行任意代码,因此在使用

-

优点

- 灵活性:

pickle模块可以处理几乎所有 Python 对象,包括自定义类实例。 - 方便性:通过简单的

pickle.dump和pickle.load函数,可以轻松实现对象的序列化和反序列化。

- 灵活性:

-

使用场景

- 数据持久化:将对象保存到文件中,以便稍后恢复。

- 网络传输:通过网络发送 Python 对象。

- 缓存:将计算结果缓存起来,以便后续快速访问。

解释 *args 和 **kwargs?

-

概述

在 Python 中,

*args和**kwargs是用于函数定义中以处理可变数量的参数的两种特殊语法。它们使函数能够接受任意数量的位置参数和关键字参数,这在编写灵活且通用的函数时非常有用。 -

*args(位置参数)*args允许你传递可变数量的位置参数给函数。在函数内部,这些参数将被收集到一个元组中。1

2

3

4

5

6

7def my_function(*args):

for arg in args:

print(arg)

my_function(1, 2, 3, 4) # 输出: 1 2 3 4 -

**kwargs(关键字参数)**kwargs允许你传递可变数量的关键字参数给函数。在函数内部,这些参数将被收集到一个字典中。1

2

3

4

5

6

7

8

9

10

11def my_function(**kwargs):

for key, value in kwargs.items():

print(f"{key}: {value}")

my_function(name="Alice", age=30, city="New York")

# 输出:

# name: Alice

# age: 30

# city: New York -

组合使用

你可以在同一个函数中同时使用

*args和**kwargs,这使得函数能够同时接受任意数量的位置参数和关键字参数。不过,顺序很重要:*args必须在**kwargs之前出现。1

2

3

4

5

6

7

8

9

10def my_function(*args, **kwargs):

print("Arguments:", args)

print("Keyword arguments:", kwargs)

my_function(1, 2, 3, name="Alice", age=30)

# 输出:

# Arguments: (1, 2, 3)

# Keyword arguments: {'name': 'Alice', 'age': 30} -

使用场景

- 灵活参数传递:当你编写的函数需要接受不固定数量的参数时,

*args和**kwargs可以提供很大的灵活性。 - 函数包装器:在编写装饰器时,通常需要使用

*args和**kwargs以确保装饰器能够处理各种类型的被装饰函数。 - 继承和扩展:在面向对象编程中,子类需要调用父类的方法并传递额外的参数时,这种用法也很常见。

- 灵活参数传递:当你编写的函数需要接受不固定数量的参数时,

-

总结

*args用于接收任意数量的位置参数,并将它们存储为一个元组。**kwargs用于接收任意数量的关键字参数,并将它们存储为一个字典。- 可以将

*args和**kwargs组合使用,以创建更加灵活且通用的函数。

类和对象有什么区别?

- 定义与实例

- 类是一个模板,用于定义一组具有相同属性和方法的对象。

- 对象是类的实例,是根据类创建的实际实体。

- 属性与方法

- 类定义了属性和方法,但不包含实际数据。

- 对象包含实际的数据,并且可以调用类中定义的方法。

- 内存分配

- 类不占用实例的内存,它只是一个定义。

- 对象占用内存,每创建一个对象都会在内存中分配空间。

- 通用性与具体性

- 类是通用的,它描述了一类对象的共同特性。

- 对象是具体的,它是类的具体实现,包含实际的属性值。

Python 中 OOPS 是什么?

OOPS(Object-Oriented Programming System)是面向对象编程系统的缩写。在Python中,OOPS是一种编程范式,它基于对象和类来组织代码。面向对象编程使得代码更具模块化、可重用、可扩展和易于维护。

什么是抽象?

-

概述

在面向对象编程(OOP)中,抽象(Abstraction)是一种概念和技术,它通过隐藏复杂的实现细节,只向用户暴露必要的部分,从而简化程序设计和使用。抽象通过接口和抽象类来实现,允许程序员专注于高层次的设计,而不需要关心底层的实现细节。

-

关键点

- 隐藏复杂性:抽象通过隐藏复杂的实现细节,使系统更易于理解和使用。

- 定义接口:通过定义清晰的接口,使得不同部分之间的交互更加简单和明确。

- 提高可维护性:抽象使得代码更加模块化,便于维护和扩展。

-

抽象类(Abstract Class)

抽象类是一种不能实例化的类,它可以包含抽象方法(没有实现的方法)。抽象类通常用于定义子类的通用接口和必须实现的方法。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28from abc import ABC, abstractmethod

class Animal(ABC):

def speak(self):

pass

class Dog(Animal):

def speak(self):

return "Woof!"

class Cat(Animal):

def speak(self):

return "Meow!"

# 不能实例化抽象类

# my_animal = Animal() # 这会引发错误

my_dog = Dog()

my_cat = Cat()

print(my_dog.speak()) # 输出: Woof!

print(my_cat.speak()) # 输出: Meow! -

抽象的优点

- 代码重用:通过定义抽象类和接口,可以在不同子类中重用通用的代码和接口。

- 模块化:抽象使得代码更加模块化,更易于理解和维护。

- 灵活性和可扩展性:通过使用抽象,可以更容易地扩展系统而不需要修改现有代码。

什么是封装?

-

概述

封装(Encapsulation)是面向对象编程(OOP)的一个核心概念。它指的是将数据(属性)和操作数据的方法(行为)组合在一个单独的单元中,并控制对这些数据的访问。这种机制提供了数据隐藏和保护的功能,使得数据只能通过规定的接口(方法)进行访问和修改。

-

关键点

- 数据隐藏:封装通过限制直接访问对象的某些组件,保护对象的内部状态不被外部直接修改。

- 保护和控制:封装提供了一种机制,可以控制数据访问和修改的权限。

- 模块化:封装使得代码更加模块化,便于维护和理解。

-

如何实现封装

- 在Python中,可以通过属性的访问级别(公共、公有、私有)来实现封装。

- 公共属性和方法(Public)

公共属性和方法可以在类的外部访问和修改。1

2

3

4

5

6

7

8

9

10

11

12

13

14class Dog:

def __init__(self, name, age):

self.name = name # 公共属性

self.age = age # 公共属性

def bark(self):

return f"{self.name} is barking."

my_dog = Dog("Buddy", 3)

print(my_dog.name) # 输出: Buddy

my_dog.name = "Max"

print(my_dog.name) # 输出: Max - 私有属性和方法(Private)

私有属性和方法通过在属性或方法名称前加上双下划线(__)来实现,只能在类的内部访问,不能在外部直接访问。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21class Dog:

def __init__(self, name, age):

self.__name = name # 私有属性

self.__age = age # 私有属性

def __bark(self): # 私有方法

return f"{self.__name} is barking."

def get_name(self): # 公共方法用于访问私有属性

return self.__name

def set_name(self, name): # 公共方法用于修改私有属性

self.__name = name

my_dog = Dog("Buddy", 3)

# print(my_dog.__name) # 这会引发错误

print(my_dog.get_name()) # 输出: Buddy

my_dog.set_name("Max")

print(my_dog.get_name()) # 输出: Max - 属性方法(Property Method)

Python提供了@property装饰器,可以将方法转换为属性,从而实现更灵活的封装。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19class Dog:

def __init__(self, name, age):

self.__name = name # 私有属性

self.__age = age # 私有属性

def name(self):

return self.__name

def name(self, name):

self.__name = name

my_dog = Dog("Buddy", 3)

print(my_dog.name) # 输出: Buddy

my_dog.name = "Max"

print(my_dog.name) # 输出: Max

-

封装的优点

- 数据保护:封装通过隐藏数据,防止外部代码意外或恶意地修改对象的内部状态。

- 简化接口:封装提供了简单的接口,隐藏了复杂的实现细节,使得对象的使用更加简洁和直观。

- 模块化:封装使得代码更加模块化,便于维护和理解。

- 灵活性:封装允许对象的内部实现发生变化,而不会影响到外部代码。

什么是多态?

-

概述

多态(Polymorphism)是面向对象编程(OOP)的一个重要特性。它允许对象以不同的形式表现自己,即对象可以是不同类型的实例,并且能够在共享相同接口的情况下,执行不同的行为。这种能力使得代码更加灵活和可扩展。

-

多态的关键点

- 方法重写(Override):子类可以重写父类的方法,从而在调用相同方法时表现出不同的行为。

- 接口一致性:不同类可以实现相同的方法接口,从而可以互换使用,而不需要改变调用代码。

- 动态绑定:在运行时根据实际对象的类型决定调用哪个方法。

-

多态的实现方式

多态通常通过继承和接口(或抽象基类)来实现。在Python中,可以通过继承和方法重写来实现多态。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25class Animal:

def speak(self):

pass

class Dog(Animal):

def speak(self):

return "Woof!"

class Cat(Animal):

def speak(self):

return "Meow!"

def make_animal_speak(animal):

print(animal.speak())

my_dog = Dog()

my_cat = Cat()

make_animal_speak(my_dog) # 输出: Woof!

make_animal_speak(my_cat) # 输出: Meow!在这个示例中,

Animal是一个基类,它定义了一个空的speak方法。Dog和Cat类继承了Animal并重写了speak方法。函数make_animal_speak可以接受任何Animal类型的对象,并调用其speak方法,而不需要关心具体对象的类型。 -

接口一致性

通过接口一致性,不同类可以实现相同的方法,从而可以互换使用这些类的实例。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30class Shape:

def area(self):

pass

class Rectangle(Shape):

def __init__(self, width, height):

self.width = width

self.height = height

def area(self):

return self.width * self.height

class Circle(Shape):

def __init__(self, radius):

self.radius = radius

def area(self):

return 3.14 * self.radius ** 2

shapes = [Rectangle(2, 3), Circle(1)]

for shape in shapes:

print(f"Area: {shape.area()}")

# 输出:

# Area: 6

# Area: 3.14在这个示例中,不同的形状类(

Rectangle和Circle)实现了相同的接口area方法。通过这种方式,可以在不修改调用代码的情况下,轻松地扩展新类型的形状。 -

多态的优点

- 代码重用:通过多态,可以编写通用的代码来处理不同类型的对象。

- 灵活性:多态使得代码更加灵活,可以轻松地扩展新类型,而不需要修改现有代码。

- 易于维护:通过多态,可以将不同的行为封装在不同的类中,使得代码更易于维护。

- 接口统一:通过定义统一的接口,可以使得不同类可以互换使用,从而提高代码的可读性和一致性。

什么是 Python 中的猴子补丁?

-

概述

猴子补丁(Monkey Patching)是指在运行时动态地修改或扩展类或模块的方法和属性。这种技术可以在不修改原始代码的情况下,改变程序的行为。虽然猴子补丁在某些情况下非常有用,但它也可能导致代码难以维护和调试,因为它改变了程序原本的行为。

-

常见用途

- 修复第三方库中的错误:如果你发现一个第三方库有一个错误,但你无法等待官方修复,你可以使用猴子补丁来临时修复这个错误。

- 添加或修改功能:你可以使用猴子补丁在运行时添加或修改类或模块的功能,而不需要直接修改源代码。

- 测试:在测试环境中,猴子补丁可以用来模拟某些行为或状态。

-

示例1:修改类的方法

假设我们有一个简单的类

Dog,我们想在运行时修改它的bark方法。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18class Dog:

def bark(self):

return "Woof!"

my_dog = Dog()

print(my_dog.bark()) # 输出: Woof!

# 使用猴子补丁修改 bark 方法

def new_bark(self):

return "Meow!"

Dog.bark = new_bark

print(my_dog.bark()) # 输出: Meow!在这个示例中,我们定义了一个

Dog类和一个bark方法。然后,我们在运行时用一个新的new_bark方法替换了原始的bark方法。 -

示例2:修复第三方库中的错误

假设我们在使用一个第三方库

some_library,并且发现其中一个类SomeClass的some_method方法有一个错误,我们可以使用猴子补丁来修复它。1

2

3

4

5

6

7

8

9

10

11

12

13

14import some_library

def fixed_some_method(self):

# 修复后的实现

return "Fixed!"

some_library.SomeClass.some_method = fixed_some_method

# 测试修复后的方法

instance = some_library.SomeClass()

print(instance.some_method()) # 输出: Fixed!在这个示例中,我们导入了一个第三方库

some_library,并用一个新的fixed_some_method方法替换了SomeClass的some_method方法。 -

注意事项

虽然猴子补丁在某些情况下非常有用,但它也有一些潜在的风险和缺点:

- 可维护性:猴子补丁可能使代码变得难以维护,因为它改变了程序的原本行为,并且这种改变可能不明显。

- 兼容性:如果第三方库更新,它们可能会破坏你的猴子补丁,从而导致不可预见的问题。

- 调试困难:由于猴子补丁在运行时动态地修改了代码,它可能使调试变得更加困难。

-

最佳实践

- 文档化:确保你已经充分地文档化了猴子补丁的原因和实现,以便其他开发者能够理解和维护代码。

- 测试:在引入猴子补丁时,确保你已经进行了充分的测试,以验证其行为是正确的。

- 避免过度使用:尽量避免在生产代码中过度使用猴子补丁,除非确实没有其他更好的解决方案。

Python 支持多重继承吗?

-

简答

是的,Python 支持多重继承,这意味着一个类可以继承多个父类。多重继承允许一个子类同时从多个父类继承属性和方法,从而实现更复杂的行为和功能。然而,多重继承也带来了复杂性,主要是由于潜在的命名冲突和继承顺序的问题。

-

多重继承的基本语法

在Python中,通过在类定义时括号内列出多个父类的名称来实现多重继承。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18class Parent1:

def method1(self):

print("Parent1 method1")

class Parent2:

def method2(self):

print("Parent2 method2")

class Child(Parent1, Parent2):

pass

child = Child()

child.method1() # 输出: Parent1 method1

child.method2() # 输出: Parent2 method2在这个例子中,

Child类继承了Parent1和Parent2,因此它可以访问这两个父类的method1和method2方法。 -

方法解析顺序(MRO)

-

概述

多重继承引入了一个问题,即在多个父类中可能存在相同的方法或属性,Python需要知道应该调用哪个父类的方法。Python通过方法解析顺序(Method Resolution Order, MRO)来解决这个问题。

-

MRO的规则

MRO决定了调用方法时的搜索顺序,Python 采用C3线性化算法来计算MRO,这是一种复杂的算法,但它遵循以下基本原则:

- 子类优先原则:在MRO中,子类会优先于父类被搜索。

- 父类从左到右:在MRO中,父类会按照在类定义中列出的顺序被搜索。

- 一次排除原则:每个类在MRO中只出现一次。

你可以使用

__mro__属性或mro()方法来查看一个类的MRO。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20class Parent1:

def method(self):

print("Parent1 method")

class Parent2:

def method(self):

print("Parent2 method")

class Child(Parent1, Parent2):

pass

print(Child.__mro__)

# 输出: (<class '__main__.Child'>, <class '__main__.Parent1'>, <class '__main__.Parent2'>, <class 'object'>)

print(Child.mro())

# 输出: [<class '__main__.Child'>, <class '__main__.Parent1'>, <class '__main__.Parent2'>, <class 'object'>]

-

-

示例:使用多重继承

以下是一个多重继承的例子,它展示了如何从多个父类继承方法并处理命名冲突。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18class Parent1:

def greet(self):

return "Hello from Parent1"

class Parent2:

def greet(self):

return "Hello from Parent2"

class Child(Parent1, Parent2):

def greet(self):

return super().greet() + " and Child"

child = Child()

print(child.greet()) # 输出: Hello from Parent1 and Child在这个例子中,

Child类通过super()调用了Parent1的greet方法,因为Parent1在MRO中优先于Parent2。 -

注意事项

多重继承虽然强大,但也增加了代码的复杂性。以下是一些使用多重继承时需要注意的事项:

- 命名冲突:在多个父类中可能存在相同的方法或属性,容易引发命名冲突。在设计类时应尽量避免这种情况。

- MRO的复杂性:理解并正确使用MRO对于确保代码正确运行非常重要。

- 调试困难:多重继承使得代码的行为更加难以预测和调试,因此在使用多重继承时应尽量保持代码简洁和清晰。

Python 中的 zip 函数是什么?

-

概述

zip函数是 Python 中的一个内置函数,它用于将多个可迭代对象(如列表、元组等)“压缩”在一起,生成一个由元组组成的迭代器。每个元组包含来自每个可迭代对象的对应元素。 -

基本语法

1

zip(*iterables)

其中,

*iterables表示可以传入多个可迭代对象。 -

示例1:压缩两个列表

1

2

3

4

5

6

7list1 = [1, 2, 3]

list2 = ['a', 'b', 'c']

zipped = zip(list1, list2)

print(list(zipped))

# 输出: [(1, 'a'), (2, 'b'), (3, 'c')]在这个例子中,

list1和list2被压缩成一个由元组组成的迭代器,然后通过list()函数将其转化为列表。 -

示例2:压缩多个列表

1

2

3

4

5

6

7

8list1 = [1, 2, 3]

list2 = ['a', 'b', 'c']

list3 = [True, False, True]

zipped = zip(list1, list2, list3)

print(list(zipped))

# 输出: [(1, 'a', True), (2, 'b', False), (3, 'c', True)]在这个示例中,三个列表被压缩在一起,每个生成的元组包含来自三个列表的对应元素。

-

示例3:处理长度不等的列表

1

2

3

4

5

6

7list1 = [1, 2, 3]

list2 = ['a', 'b']

zipped = zip(list1, list2)

print(list(zipped))

# 输出: [(1, 'a'), (2, 'b')]当可迭代对象的长度不同时,

zip函数会以最短的可迭代对象为准,生成的迭代器的长度与最短的可迭代对象相同。 -

解压缩(Unzipping)

通过使用

zip函数的反操作,可以将压缩的可迭代对象解压缩回原来的形式。使用zip(*zipped)可以解压缩。1

2

3

4

5zipped = [(1, 'a'), (2, 'b'), (3, 'c')]

list1, list2 = zip(*zipped)

print(list1) # 输出: (1, 2, 3)

print(list2) # 输出: ('a', 'b', 'c') -

zip 与循环

zip函数常与for循环结合使用,以同时迭代多个可迭代对象。1

2

3

4

5

6

7

8

9

10list1 = [1, 2, 3]

list2 = ['a', 'b', 'c']

for num, char in zip(list1, list2):

print(f'Number: {num}, Character: {char}')

# 输出:

# Number: 1, Character: a

# Number: 2, Character: b

# Number: 3, Character: c这种使用方式使得处理成对数据更加方便和直观。

Python 中的 all 函数是什么?

-

概述

all函数是 Python 中的一个内置函数,用于判断一个可迭代对象中的所有元素是否都为真(True)。如果可迭代对象中的所有元素都为真,则返回True,否则返回False。如果可迭代对象为空,all函数返回True。 -

基本语法

1

all(iterable)

iterable:一个可迭代对象,如列表、元组、集合等。 -

示例1:所有元素都为真

1

2

3

4values = [True, True, True]

result = all(values)

print(result) # 输出: True在这个例子中,列表

values中的所有元素都为True,因此all函数返回True。 -

示例2:存在元素为假

1

2

3

4values = [True, False, True]

result = all(values)

print(result) # 输出: False在这个例子中,列表

values中存在一个False元素,因此all函数返回False。 -

示例3:空可迭代对象

1

2

3

4values = []

result = all(values)

print(result) # 输出: True在这个例子中,列表

values为空,根据all函数的定义,它返回True。 -

与逻辑运算结合使用

all函数常用于需要检查多个条件是否都为真的情况,特别是在过滤和验证数据时非常有用。1

2

3

4numbers = [2, 4, 6, 8, 10]

result = all(num % 2 == 0 for num in numbers)

print(result) # 输出: True在这个例子中,我们用列表推导生成一个布尔值列表,检查所有数字是否都是偶数。由于所有数字都是偶数,

all函数返回True。

Python 中的访问权限?

-

公有(Public)

在 Python 中,默认情况下所有属性和方法都是公有的。公有属性和方法可以在类的外部进行访问和修改。

1

2

3

4

5

6

7

8

9

10

11

12class MyClass:

def __init__(self, value):

self.value = value

def public_method(self):

print("This is a public method")

obj = MyClass(10)

print(obj.value) # 访问公有属性

obj.public_method() # 调用公有方法 -

受保护(Protected)

在 Python 中,通过在属性或方法名前加一个下划线

_来表示受保护的属性或方法。受保护的属性和方法通常不建议在类的外部访问,尽管从技术上讲,它们仍然是可访问的。这是一种约定,表示这些成员不应该被外部代码直接使用。1

2

3

4

5

6

7

8

9

10

11

12class MyClass:

def __init__(self, value):

self._value = value

def _protected_method(self):

print("This is a protected method")

obj = MyClass(10)

print(obj._value) # 虽然不建议,但还是可以访问受保护属性

obj._protected_method() # 虽然不建议,但还是可以调用受保护方法 -

私有(Private)

通过在属性或方法名前加两个下划线

__,可以使其成为私有成员。私有成员不能在类的外部直接访问。Python 实现私有成员的机制是名称改写(name mangling),即在内部将成员名称改写为_ClassName__memberName的形式。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16class MyClass:

def __init__(self, value):

self.__value = value

def __private_method(self):

print("This is a private method")

obj = MyClass(10)

# print(obj.__value) # 会报错,无法直接访问私有属性

# obj.__private_method() # 会报错,无法直接调用私有方法

# 通过名称改写可以访问私有成员(不建议)

print(obj._MyClass__value) # 正确访问私有属性

obj._MyClass__private_method() # 正确调用私有方法

Web 相关

Post 和 Get 的区别是什么?

-

数据传输方式

GET:

- URL 中传递参数:GET 请求将数据附加在 URL 的查询字符串中(即

?后面的部分)。 - 数据量限制:因为 URL 长度有限,GET 请求传输的数据量有限(具体限制取决于浏览器和服务器,但一般不超过 2000 字符)。

- 数据明文可见:由于数据在 URL 中明文传递,敏感信息不宜使用 GET 请求传输。

POST:

- 请求体中传递数据:POST 请求将数据包含在 HTTP 请求体中。

- 数据量较大:POST 请求传输的数据量没有严格限制,适合发送大量数据。

- 数据不明文可见:虽然数据仍可能被截获,但在 URL 中不可见,安全性相对较高。

- URL 中传递参数:GET 请求将数据附加在 URL 的查询字符串中(即

-

缓存机制

GET:

- 可缓存:GET 请求通常是幂等的(多次请求结果相同),浏览器和代理服务器通常会缓存 GET 请求的响应。

POST:

- 不可缓存:POST 请求可能会改变服务器的状态,浏览器和代理服务器通常不会缓存 POST 请求的响应。

-

数据长度限制

GET:

- 有限制:受限于浏览器和服务器对 URL 长度的限制,通常不超过 2000 字符。

POST:

- 无明显限制:可传输的数据量较大,受限于服务器配置和内存大小。

-

安全性

GET:

- 安全性较低:GET 请求的数据会显示在 URL 中,容易被截获和记录,不适合传输敏感信息。

POST:

- 安全性较高:虽然数据仍可能被截获,但在 URL 中不可见,适合传输敏感信息。配合 HTTPS 可以进一步提高安全性。

-

使用场景

GET:

- 获取数据:适用于从服务器获取数据,不会对服务器产生副作用。

- 查询操作:适用于查询操作,如搜索、读取数据等。

- 导航链接:适用于超链接导航,因为链接点击通常是幂等的。

POST:

- 提交数据:适用于向服务器提交数据,会对服务器产生副作用。

- 表单提交:适用于表单提交,如用户注册、登录、上传文件等。

- 修改操作:适用于涉及数据修改的操作,如添加、更新或删除数据。

-

幂等性

GET:

- 幂等:多次相同的 GET 请求,对服务器的影响是相同的,不会改变服务器的状态。

POST:

- 非幂等:多次相同的 POST 请求,可能会对服务器产生不同的副作用,如多次提交表单可能导致重复的数据创建。

Cookie 和 Session 的区别是什么?

-

存储位置

Cookie:

- 客户端存储:Cookie 存储在客户端浏览器中,客户端可以查看、修改和删除 Cookie。

Session:

- 服务器存储:Session 存储在服务器端,客户端浏览器只保存一个 Session ID,该 ID 用于标识服务器端的会话数据。

-

生命周期

Cookie:

- 持久性:Cookie 可以设置过期时间,持久化存储。即使关闭浏览器,Cookie 仍然存在,直到达到过期时间或被删除。

- 会话性:也可以不设置过期时间,这种 Cookie 称为会话 Cookie(Session Cookie),在浏览器关闭时自动删除。

Session:

- 会话性:Session 只在会话期间有效,默认情况下当用户关闭浏览器或会话超时后,Session 失效。

- 持久化:可以通过配置实现长时间有效的 Session(如持久化到数据库或文件系统),但这取决于服务器的具体实现。

-

安全性

Cookie:

- 安全性较低:由于 Cookie 存储在客户端,容易被截获、篡改和伪造。不建议在 Cookie 中存储敏感信息,可以使用 HTTP Only 和 Secure 标志来提高安全性。

- HTTP Only:防止客户端脚本(如 JavaScript)访问 Cookie。

- Secure:确保 Cookie 只能通过 HTTPS 传输。

Session:

- 安全性较高:Session 数据存储在服务器端,相对来说更安全。即使 Session ID 被截获,攻击者也很难获取到具体的会话数据。

- 安全性较低:由于 Cookie 存储在客户端,容易被截获、篡改和伪造。不建议在 Cookie 中存储敏感信息,可以使用 HTTP Only 和 Secure 标志来提高安全性。

-

数据存储容量

Cookie:

- 容量有限:每个 Cookie 的大小通常不能超过 4KB,不同浏览器对单个域名下 Cookie 的总数量有限制(通常为 20-50 个)。

Session:

- 容量较大:服务器端存储的 Session 数据没有严格的大小限制,可以存储大量的数据,受限于服务器的内存和存储空间。

-

用途

Cookie:

- 持久存储:适用于需要在客户端存储的持久数据,如用户偏好设置、购物车信息等。

- 跨请求数据共享:Cookie 可以在不同请求间共享数据。

Session:

- 会话管理:适用于需要在服务器端存储的临时数据,如用户登录状态、临时数据等。

- 敏感数据存储:适合存储敏感数据,因为数据不直接暴露给客户端。

-

性能

Cookie:

- 性能影响小:每次请求都会自动带上 Cookie,有时会增加请求和响应的大小,但通常影响较小。

- 适用于小数据量:因为存储在客户端,适用于较小的数据量。

Session:

- 性能依赖服务器:会话数据存储在服务器端,性能取决于服务器的处理能力和存储机制。并发用户较多时,服务器压力较大。

- 适用于大数据量:因为存储在服务器端,适用于较大的数据量。

HTTP 的三次握手和四次挥手

-

HTTP 的三次握手

三次握手(Three-Way Handshake)是客户端和服务器在建立TCP连接时所进行的三步过程。其目的是确保双方都能接收和发送数据,并且为数据传输的初始序列号进行同步。

- 第一次握手(SYN):

- 客户端向服务器发送一个SYN(同步序列号)包,请求建立连接。

- 报文段:SYN=1,Seq=x

- 客户端进入SYN_SENT状态。

- 第二次握手(SYN+ACK):

- 服务器收到客户端的SYN包后,确认连接请求,并向客户端发送一个SYN+ACK(同步序列号+确认序列号)包。

- 报文段:SYN=1,ACK=1,Seq=y,Ack=x+1

- 服务器进入SYN_RCVD状态。

- 第三次握手(ACK):

- 客户端收到服务器的SYN+ACK包后,向服务器发送一个ACK(确认序列号)包,表示已收到服务器的SYN+ACK包。

- 报文段:ACK=1,Seq=x+1,Ack=y+1

- 客户端进入ESTABLISHED状态,服务器也进入ESTABLISHED状态,TCP连接建立成功。

图示:

1

2

3

4

5

6

7

8

9

10

11客户端 服务器

| SYN=x |

|-------------------------->|

| |

| SYN=y, ACK=x+1 |

|<--------------------------|

| |

| ACK=y+1 |

|-------------------------->|

| | - 第一次握手(SYN):

-

HTTP 的四次挥手

四次挥手(Four-Way Handshake)是客户端和服务器在终止TCP连接时所进行的四步过程。其目的是确保双方都已完成数据传输,并且连接可以安全地关闭。

- 第一次挥手(FIN):

- 客户端向服务器发送一个FIN(结束标志)包,表示希望主动关闭连接。

- 报文段:FIN=1,Seq=u

- 客户端进入FIN_WAIT_1状态。

- 第二次挥手(ACK):

- 服务器收到客户端的FIN包后,向客户端发送一个ACK(确认序列号)包,确认已收到关闭请求。

- 报文段:ACK=1,Seq=v,Ack=u+1

- 服务器进入CLOSE_WAIT状态,客户端进入FIN_WAIT_2状态。

- 第三次挥手(FIN):

- 服务器向客户端发送一个FIN包,表示希望关闭连接。

- 报文段:FIN=1,Seq=w

- 服务器进入LAST_ACK状态。

- 第四次挥手(ACK):

- 客户端收到服务器的FIN包后,向服务器发送一个ACK包,确认已收到关闭请求。

- 报文段:ACK=1,Seq=u+1,Ack=w+1

- 客户端进入TIME_WAIT状态,等待一段时间(通常是2MSL,最长报文段生命周期)以确保服务器已收到ACK包。随后,客户端进入CLOSED状态。服务器接收到ACK包后,也进入CLOSED状态,连接关闭。

图示:

1

2

3

4

5

6

7

8

9

10

11

12

13

14客户端 服务器

| FIN=u |

|-------------------------->|

| |

| ACK=u+1 |

|<--------------------------|

| |

| FIN=w |

|<--------------------------|

| |

| ACK=w+1 |

|-------------------------->|

| | - 第一次挥手(FIN):

-

总结

- 三次握手确保 TCP 连接的可靠建立,包括双方的同步和初始序列号的确认。

- 四次挥手确保 TCP 连接的可靠终止,允许双方完成数据传输并安全关闭连接。

AJAX 的优缺点?

-

概述

AJAX(Asynchronous JavaScript and XML)是一种用于创建快速动态网页的技术,它允许网页在不重新加载整个页面的情况下与服务器进行数据交换。

-

AJAX 的优点

- 用户体验更好:

- AJAX允许在不刷新页面的情况下更新页面的部分内容,这使得应用程序响应更加迅速,从而提高了用户体验。

- 减少带宽使用:

- 由于只更新页面的一部分,AJAX 请求通常比重新加载整个页面需要的带宽更少,这可以显著减少服务器和客户端之间的数据传输量。

- 提升性能:

- 由于数据传输量减少,并且请求是异步处理的,页面加载速度和响应时间显著提高,从而提升了整体性能。

- 异步处理:

- AJAX的异步特性允许用户在等待服务器响应时继续与页面进行交互,提高了用户的操作体验。

- 增强的交互性:

- AJAX使得创建动态、交互性强的网页应用成为可能,像电子邮件客户端、实时聊天应用、地图服务等都能得益于此。

- 分离前后端逻辑:

- AJAX请求可以将前端页面展示与后端数据处理逻辑分开,前后端可以独立开发和维护。

- 用户体验更好:

-

AJAX 的缺点

- 搜索引擎优化(SEO)问题:

- 由于内容是通过JavaScript动态加载的,而不是直接在页面HTML中,搜索引擎可能无法抓取这些动态内容,从而影响SEO效果。

- 浏览器兼容性问题:

- 尽管现代浏览器对AJAX支持较好,但早期的浏览器或某些特定环境可能不完全支持AJAX,导致兼容性问题。

- 可能增加复杂性:

- 实现和调试AJAX请求和响应可能需要更多的代码和复杂性,特别是在处理异步操作、错误处理和状态管理方面。

- 历史记录和书签问题:

- 由于AJAX动态更新页面内容而不改变URL,传统的浏览器历史记录和书签功能可能无法正常工作,这对用户导航体验产生一定影响。

- 安全问题:

- AJAX请求存在安全隐患,例如跨站脚本攻击(XSS)和跨站请求伪造(CSRF)。需要采取额外的措施来确保安全,如验证和授权机制。

- 依赖JavaScript:

- 如果用户禁用了JavaScript或使用了不支持JavaScript的浏览器,AJAX功能将无法正常工作,从而影响网页的功能和用户体验。

- 搜索引擎优化(SEO)问题:

-

总结

AJAX技术在提升用户体验、减少带宽使用和提升性能方面带来了诸多好处,使得网页应用更加动态和交互性强。然而,开发者在使用AJAX时也需要权衡其缺点,如SEO影响、浏览器兼容性、安全问题等,并采取相应的措施来优化和保护应用程序。合理使用AJAX可以大大提高网页的交互体验和性能,但也需要谨慎处理可能的复杂性和潜在的安全风险。

HTTP 和 HTTPS 的区别?

-

数据加密

- HTTP:HTTP 协议在数据传输过程中不进行加密。这意味着数据在客户端和服务器之间以纯文本形式传输,容易被中间人截获和篡改。

- HTTPS:HTTPS 在数据传输过程中使用 SSL/TLS 协议对数据进行加密。加密的数据在传输过程中无法被第三方解读,从而提供了更高的安全性。

-

端口号

- HTTP:默认使用端口号 80。

- HTTPS:默认使用端口号 443。

-

安全性

- HTTP:由于数据以纯文本形式传输,HTTP 协议容易受到各种类型的攻击,如中间人攻击(Man-in-the-Middle Attack)和窃听攻击。

- HTTPS:通过使用 SSL/TLS 加密数据传输,HTTPS 提供了数据完整性和隐私性,防止数据在传输过程中被截获或篡改。

-

SSL/TLS 证书

- HTTP:不需要 SSL/TLS 证书。

- HTTPS:需要一个由受信任的证书颁发机构(CA,Certificate Authority)签发的 SSL/TLS 证书。证书用于验证服务器的身份,并建立安全的加密连接。

-

性能

- HTTP:由于没有加密和解密的开销,HTTP 通常比 HTTPS 性能稍高。

- HTTPS:由于加密和解密数据需要额外的计算资源,HTTPS 的性能可能比 HTTP 略低。不过,现代硬件和优化技术已经使得这个性能差异变得非常小。

-

URL 结构

- HTTP:URL 以

http://开头。 - HTTPS:URL 以

https://开头。

- HTTP:URL 以

数据库相关

MySQL 分区有哪些?

-

范围分区(RANGE Partitioning)

- 定义:基于列值的范围进行分区。

- 适用场景:适用于基于日期、数字范围等情况的分区。例如,按年份、月份来分区。

1

2

3

4

5

6

7

8

9

10

11CREATE TABLE sales

(

id INT,

sale_date DATE,

amount DECIMAL(10, 2)

) PARTITION BY RANGE (YEAR(sale_date)) (

PARTITION p2018 VALUES LESS THAN (2019),

PARTITION p2019 VALUES LESS THAN (2020),

PARTITION p2020 VALUES LESS THAN (2021)

);

-

列表分区(LIST Partitioning)

- 定义:基于枚举值进行分区。

- 适用场景:适用于列值为离散、非连续的情况。例如,基于地理区域、类别等进行分区。

1

2

3

4

5

6

7

8

9

10

11CREATE TABLE user_profiles

(

id INT,

name VARCHAR(50),

country_code CHAR(2)

) PARTITION BY LIST (country_code) (

PARTITION pNorthAmerica VALUES IN ('US', 'CA', 'MX'),

PARTITION pEurope VALUES IN ('FR', 'DE', 'GB'),

PARTITION pAsia VALUES IN ('CN', 'JP', 'IN')

);

-

哈希分区(HASH Partitioning)

- 定义:基于哈希函数的值进行分区。

- 适用场景:适用于希望均匀分布数据的情况,不需要特定的分区规则。

1

2

3

4

5

6

7CREATE TABLE orders

(

id INT,

customer_id INT,

order_date DATE

) PARTITION BY HASH (customer_id) PARTITIONS 4;

-

键值分区(KEY Partitioning)

- 定义:类似于哈希分区,但使用MySQL提供的内部哈希函数进行分区。

- 适用场景:适用于希望数据均匀分布但不想指定哈希函数的情况。

1

2

3

4

5

6

7CREATE TABLE logs

(

id INT,

log_message VARCHAR(255),

log_date DATE

) PARTITION BY KEY(id) PARTITIONS 4;

-

线性哈希分区(LINEAR HASH Partitioning)

- 定义:改进的哈希分区,使用线性哈希函数。

- 适用场景:适用于需要处理大规模分区并且希望在分区增加时保持均匀分布的情况。

1

2

3

4

5

6

7CREATE TABLE sessions

(

id INT,

user_id INT,

start_time DATETIME

) PARTITION BY LINEAR HASH (user_id) PARTITIONS 6;

-

线性键值分区(LINEAR KEY Partitioning)

- 定义:类似于线性哈希分区,但使用MySQL提供的内部线性哈希函数。

- 适用场景:适用于大规模分区并希望均匀分布数据的情况。

1

2

3

4

5

6

7CREATE TABLE events

(

id INT,

event_name VARCHAR(50),

event_date DATE

) PARTITION BY LINEAR KEY(id) PARTITIONS 6;

-

分区优缺点

-

优点

- 提升查询性能:分区可以减少查询数据的范围,从而加快查询速度。

- 简化管理:分区使得管理大表更为简单,备份、恢复、删除数据等操作可以在单个分区上进行。

- 均衡IO负载:通过分区分布,可以均衡数据库的IO负载,提升整体性能。

-

缺点

- 复杂性增加:设计和维护分区表比普通表更复杂,需要额外的规划。

- 可能增加开销:在某些情况下,分区可能增加SQL的执行开销。

- 有限制:某些索引和操作在分区表上可能受限。

-

什么是 MySQL 事务?

-

概述

MySQL事务(Transaction)是指一组逻辑上的数据库操作,这些操作要么全部成功执行,要么全部回滚,从而保持数据库的一致性。事务是数据库管理系统(DBMS)中保证数据一致性和完整性的重要机制。

-

事务的基本操作

- START TRANSACTION:显式地开始一个事务。

- COMMIT:提交事务,将事务中的所有操作永久保存到数据库。

- ROLLBACK:回滚事务,撤销事务中的所有操作,使得数据库恢复到事务开始之前的状态。

-

示例

下面是一个简单的示例,展示了如何在MySQL中使用事务:

1

2

3

4

5

6

7

8

9

10

11

12

13

14-- 开始事务

START TRANSACTION;

-- 执行一些SQL操作

INSERT INTO accounts (account_id, balance) VALUES (1, 1000);

UPDATE accounts SET balance = balance - 100 WHERE account_id = 1;

UPDATE accounts SET balance = balance + 100 WHERE account_id = 2;

-- 如果一切正常,提交事务

COMMIT;

-- 如果出错,回滚事务

ROLLBACK;

数据库事务的 ACID 四大特性

-

原子性(Atomicity)

原子性保证了事务中的所有操作要么全部完成,要么全部不完成。换句话说,事务是一个不可分割的工作单元,即使在中途出现故障,事务也能确保其操作要么全部生效,要么全部撤销,不会出现部分生效的情况。

1

2

3

4

5

6

7

8

9

10

11START TRANSACTION;

UPDATE accounts SET balance = balance - 100 WHERE account_id = 1;

UPDATE accounts SET balance = balance + 100 WHERE account_id = 2;

-- 如果操作成功,提交事务

COMMIT;

-- 如果操作失败,回滚事务

ROLLBACK; -

一致性(Consistency)

一致性保证在事务开始和结束时,数据库都处于一致的状态。这意味着所有业务规则、约束和触发器在事务完成后仍然有效。在事务中进行的操作不会破坏数据库的完整性约束,如外键约束、唯一性约束等。

示例:假设有账户转账操作,如果在转账过程中一方账户扣款成功而另一方账户加款失败,那么数据库将回滚到事务开始前的状态,保持数据一致性。

-

隔离性(Isolation)

隔离性保证一个事务的执行不会因并发事务的操作而受到影响。不同的隔离级别提供了不同程度的隔离性,常见的隔离级别包括:

- READ UNCOMMITTED:最低的隔离级别,允许读取未提交的数据,可能导致脏读。

- READ COMMITTED:只能读取已提交的数据,避免脏读,但可能出现不可重复读。

- REPEATABLE READ:确保在一个事务中的多次读取操作结果一致,避免脏读和不可重复读,但可能出现幻读。

- SERIALIZABLE:最高的隔离级别,确保完全隔离,避免脏读、不可重复读和幻读,但性能较低。

示例:

1

2

3

4

5

6

7

8SET TRANSACTION ISOLATION LEVEL REPEATABLE READ;

START TRANSACTION;

SELECT balance FROM accounts WHERE account_id = 1;

-- 其他事务在此期间对相同数据的更新不会影响当前事务

COMMIT; -

持久性(Durability)

持久性保证一旦事务提交,其对数据库的改变将永久保存,即使系统崩溃或重启,提交的事务也不会丢失。这通常通过将事务日志记录到稳定的存储(如磁盘)来实现。

1

2

3

4

5

6

7

8START TRANSACTION;

UPDATE accounts SET balance = balance - 100 WHERE account_id = 1;

UPDATE accounts SET balance = balance + 100 WHERE account_id = 2;

-- 提交事务后,数据更改将永久保存

COMMIT; -

总结

- 原子性:事务是不可分割的整体。

- 一致性:事务完成后,数据库状态依然满足所有约束。

- 隔离性:事务彼此独立执行,不受并发影响。

- 持久性:一旦提交,事务的改变永久保存。

MySQL 常用的聚合函数

| 聚合函数 | 说明 |

|---|---|

COUNT() |

统计某列的非空值的数量。 |

SUM() |

计算某列数值的总和。 |

AVG() |

计算某列数值的平均值。 |

MAX() |

返回某列的最大值。 |

MIN() |

返回某列的最小值。 |

1 | SELECT COUNT(*) FROM employees; |

MongoDB常用的聚合函数

MongoDB 提供了一系列常用的聚合操作符,用于在聚合管道(Aggregation Pipeline)中进行数据处理和计算。

| 表达式 | 描述 |

|---|---|

| $sum | 计算总和 |

| $avg | 计算平均值 |

| $min | 获取最小值 |

| $max | 获取最大值 |

| $push | 在结果文档中插入值到一个数组中 |